Blog

Webarchivierung für Alle: Mit wenigen Klicks zur Webarchivierung

Autor: Antares Reich

Webarchivierung – also das Speichern von Internetseiten für die Zukunft – wird immer wichtiger. Dafür gibt es viele Gründe. Einer der wichtigsten ist, dass immer mehr Veröffentlichungen nur noch im Internet erscheinen. In der Fachwelt nennt man das „born digital“, also „digital geboren“. Lernen Sie in diesem Blogbeitrag, wie Sie selbst Websites archivieren können – damit das Web nicht versehentlich gelöscht wird!

Daniel Gomes, der Leiter des portugiesischen Webarchivs Arquivo.pt, hat auf der diesjährigen Webarchiving Conference der IIPC (International Internet Preservation Consortium)1 erklärt: „Immer mehr Medien gibt es nur noch online. Irgendwann werden alle alten Papierveröffentlichungen digitalisiert sein – dann müssen wir die Online-Medien für die Zukunft bewahren.“

Doch nicht nur technische Entwicklungen machen Webarchivierung wichtig. Auch durch politische Ereignisse kann es passieren, dass wichtige Internetseiten plötzlich verschwinden. In den USA wurden zum Beispiel schon mehrfach offizielle Regierungswebsites von einem Tag auf den anderen gelöscht. Für die Menschen ist es dann sehr wichtig, dass die Informationen weiterhin verfügbar sind. Auch Forschungsprojekte, zum Beispiel zum Klimawandel, waren schon von solchen Löschungen betroffen.

Ein gutes Beispiel, wie digitale Inhalte gesichert werden, ist die End of Term Collection.2 Das Webrecorder-Team hat dafür eine einfache Lösung gefunden: Wenn man an eine gelöschte Internetadresse „archive.us“ anhängt, kann man die Seite weiterhin aufrufen. Zum Beispiel ist die inzwischen gelöschte Seite https://usaid.gov immer noch unter https://usaid.govarchive.us erreichbar.3

Webrecorder ist auch das Stichwort für diesen Beitrag, denn ich möchte zeigen, wie jeder ganz einfach Websites archivieren kann – mit dem Browser-Plugin ArchiveWeb.page von Webrecorder.

Was brauche ich dafür?

Das Plugin funktioniert nur mit der neuesten Version des Chrome-Browsers oder einem anderen Browser, der auf Chrome basiert (z.B. Brave oder Edge). Um das Plugin zu installieren, gehen Sie einfach auf die Website https://archiveweb.page und fügen das Plugin Ihrem Browser hinzu.

Auf der Website wird nun angezeigt, ob Ihr Browser mit dem Plugin kompatibel ist.

Damit es immer griffbereit ist, empfiehlt es sich, das Plugin zu „pinnen“. Dazu klicken Sie in Ihrem Browser auf die Erweiterungen und dann auf die Pinnnadel neben dem Plugin. So bleibt es direkt sichtbar und muss nicht erst in einem Untermenü gesucht werden.

Digitale Inhalte bewahren: Anleitung für das archiveweb.page Plugin

Jetzt zeige ich Schritt für Schritt, wie das Plugin funktioniert. Sie benötigen dafür nur zwei Dinge:

- Einen Browser, in dem das Plugin aktiviert ist

- Eine Website, die Sie archivieren möchten

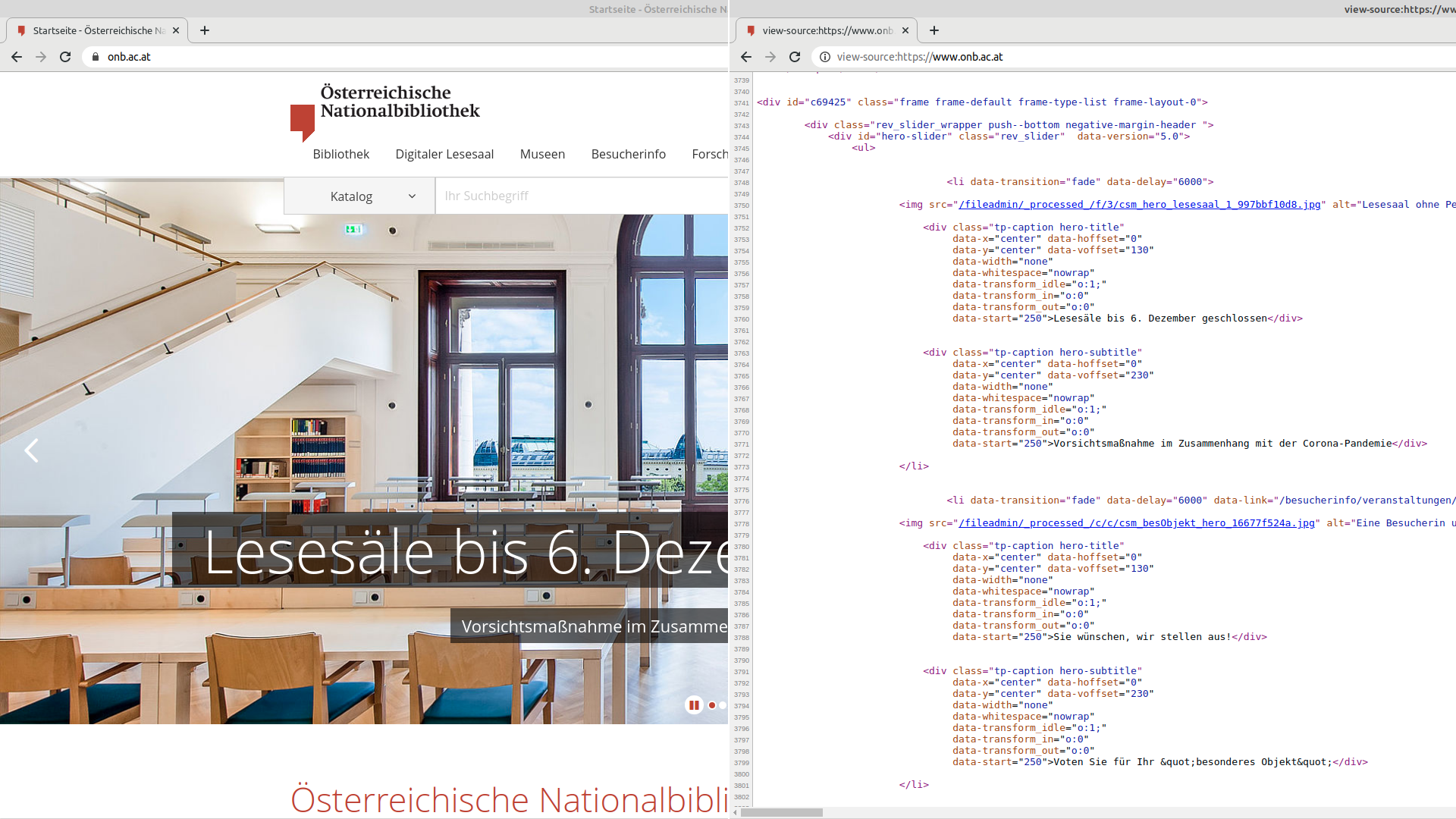

Rufen Sie im Browser die Website auf, die Sie speichern möchten – in meinem Beispiel ist das die Seite der Österreichischen Nationalbibliothek.

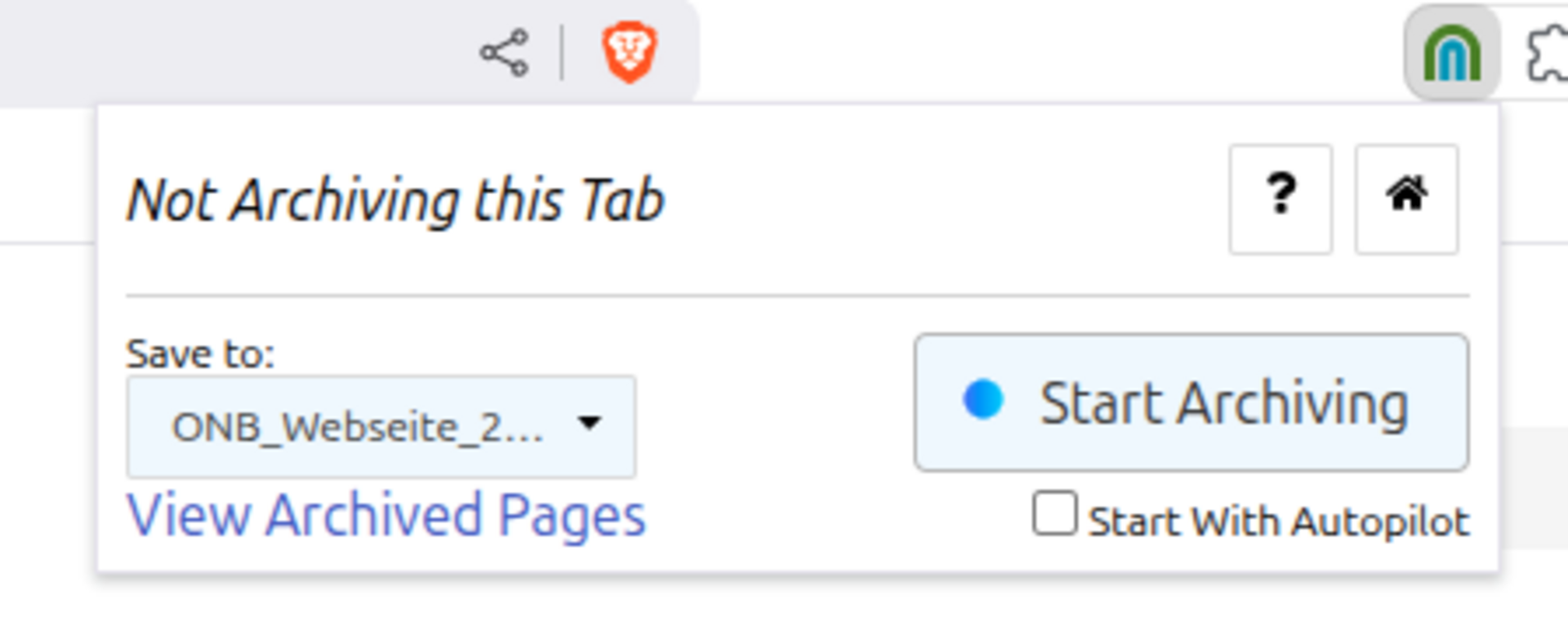

Wenn Sie das Plugin zum ersten Mal anklicken, sieht es so aus:

Um mit dem Archivieren zu starten, legen Sie eine neue „Session“ (also einen neuen Archivierungsvorgang) an. Klicken Sie dazu auf das Auswahlfeld „Save to“ und wählen dort „Neue Session starten“.

Geben Sie Ihrer neuen Archivierungs-Session einen eindeutigen Namen, zum Beispiel: ONB_Website_2025_06.

Jetzt können Sie mit „Start Archiving“ die Archivierung starten.

Die Internetseite wird dann neu geladen, und ab jetzt wird alles gespeichert, was Sie auf der Seite tun – also zum Beispiel das Herunterscrollen oder das Klicken auf Links. Wichtig: Es wird nur das archiviert, was Sie tatsächlich aufrufen! Wenn Sie also bis nach unten scrollen, wird die ganze Startseite gesichert. Das Plugin zeigt sogar an, wie groß die gespeicherten Dateien sind und wie viele Internetadressen („URLs“) gefunden wurden.

Das archiveweb.page Plugin hat eine praktische Zusatzfunktion: Mit dem „Autopilot“ können Sie sich das Scrollen sparen. Der Autopilot scrollt automatisch bis zum Seitenende und speichert dabei alles. Wenn der Autopilot fertig ist, ist „Autopilot Done“ im Plugin zu lesen.

Wenn alles gespeichert ist, klicken Sie auf „Stop Archiving“, um die Archivierung zu beenden.

Im Anschluss können Sie kontrollieren, ob alles richtig gespeichert wurde. Das ist mit dem archiveweb.page Plugin ganz einfach: Mit „View Archived Pages“ öffnet sich ein Wiedergabefenster, in dem Sie die gespeicherten Websites ansehen können – genau so, wie sie archiviert wurden.

Wenn Sie mit der Qualitätskontrolle zufrieden sind, können Sie das Archiv in einem Archivformat Ihrer Wahl für Ihr privates Archiv sichern.

Die Österreichische Nationalbibliothek bedankt sich sehr herzlich bei der Wiener Städtischen Versicherung für die Unterstützung des Webarchivs Österreich.

Zum Autor: Antares Reich, BA ist Crawl Engineer des Webarchivs Österreich an der Österreichischen Nationalbibliothek.

Fußnoten:

1 Website der IIPC: https://netpreserve.org

2 End Of Term Archive ist unter https://eotarchive.org zu finden

3 Die ganze Kollegtion vom Webrecorder Team für die End Of Terms Sammlung kann hier angesehen werden: https://govarchive.us

Wie zitiert man Webinhalte richtig?

Autor: Andreas Predikaka

Wie zitiert man Webinhalte so, dass sie auch in Zukunft nachvollziehbar bleiben? Lesen Sie, wie Webarchive und der neue Persistent Web Identifier (PWID) das Zitieren sicherer, verlässlicher und zukunftsfähiger machen.

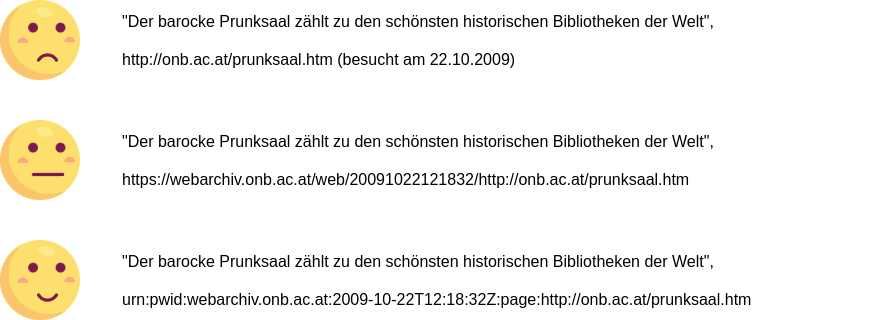

Wir alle kennen es: In wissenschaftlichen Arbeiten, Publikationen und ähnlichen Texten stehen hinter Zitaten aus dem Web Angaben wie "besucht am" oder "letzter Zugriff". Damit wird versucht, eine Quelle durch die URL und das Datum des Zugriffs nachzuweisen. Doch stellen Sie sich vor, Sie würden eine Seite aus einem Buch zitieren und gleichzeitig die Geokoordinaten des Regals angeben, aus dem Sie das Buch genommen haben – eine absurde Idee für gedruckte Publikationen. Im Web jedoch ist diese Praxis seit über 20 Jahren die Norm und wird bis heute unverändert empfohlen. Gerade beim Web, dessen Architektur und Dynamik ständige Veränderungen fördert, ist diese Zitierweise problematisch, denn "es ist niemals nachvollziehbar, ob, wann und wo das Web aktualisiert wurde"1. Es wird dabei lediglich dokumentiert, wo eine Information zu einem bestimmten Zeitpunkt abrufbar war, ohne sicherzustellen, dass diese langfristig zugänglich bleibt.

Archivieren statt Verlieren

Im Laufe der Zeit hat sich gezeigt, wie problematisch diese Praxis der Zitierung von Webquellen sein kann: Viele der ursprünglich referenzierten Inhalte sind inzwischen nicht mehr erreichbar, ein Phänomen, das als "link rot" bekannt ist. Selbst bei noch funktionierenden Links bleibt oft unklar, ob die aktuellen Inhalte, mit denen zum Zeitpunkt der Zitation übereinstimmen ("content drift")2. Webarchive spielen eine wichtige Rolle, indem sie Webinhalte sichern und zugänglich machen. Doch begrenzte Kapazitäten und rechtliche Hürden bedeuten, dass viele Inhalte nicht umfassend archiviert werden können.

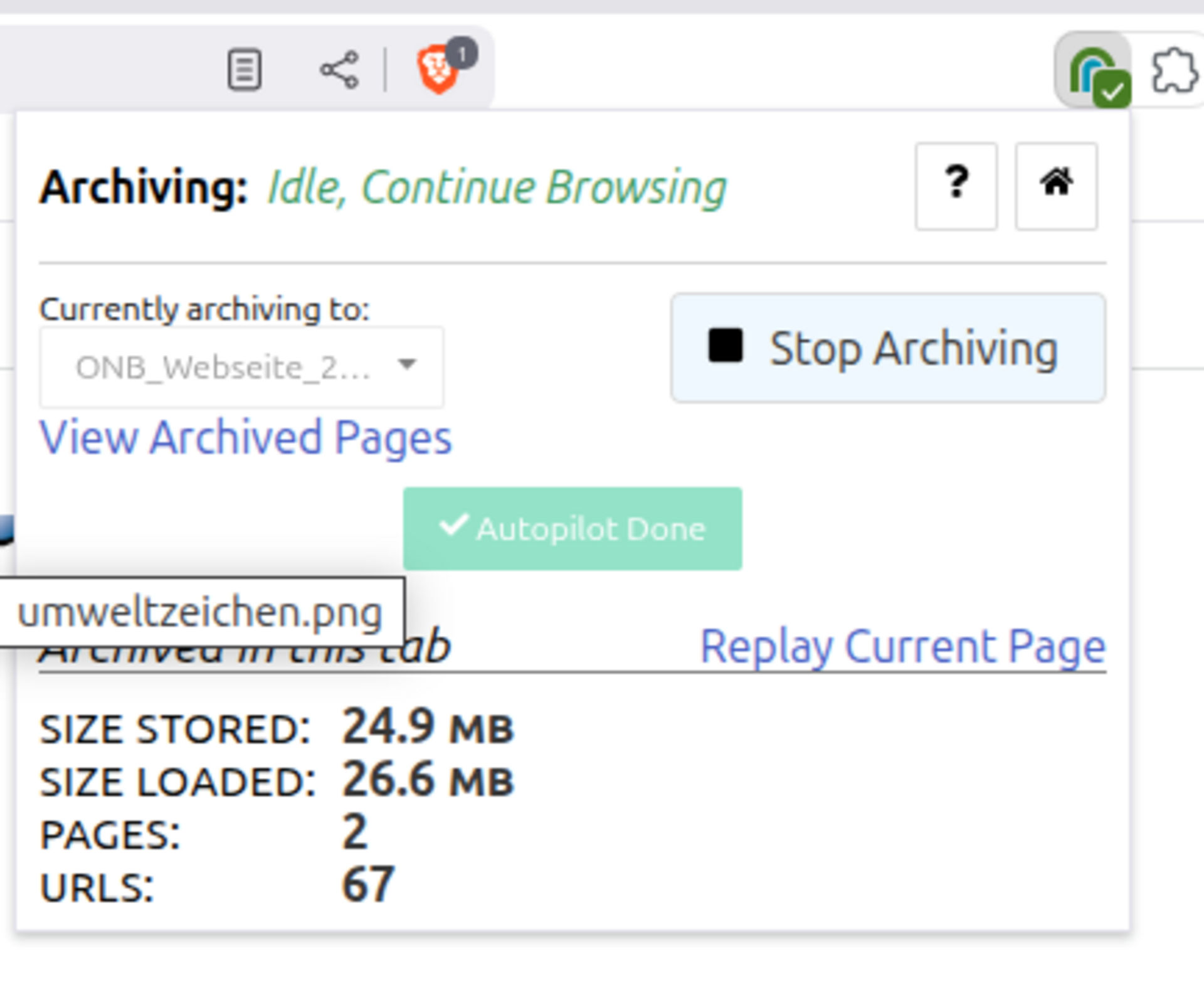

Das Zitieren einer Live-Seite ist zwar schneller, doch ein Verweis auf eine archivierte Version sichert die langfristige Zugänglichkeit und Integrität der Quelle. Das größte existierende Webarchiv, das Internet Archive, bietet öffentlichen Zugriff und ist bequem online erreichbar. Für Inhalte, die in diesem oder anderen Archiven nicht gefunden werden können, führte das Internet-Archive 2013 das Tool „Save Page Now“ ein, das Webseiten auf Wunsch archiviert und eine Archiv-URL generiert. Auch andere Archive bieten ähnliche Dienste an.3

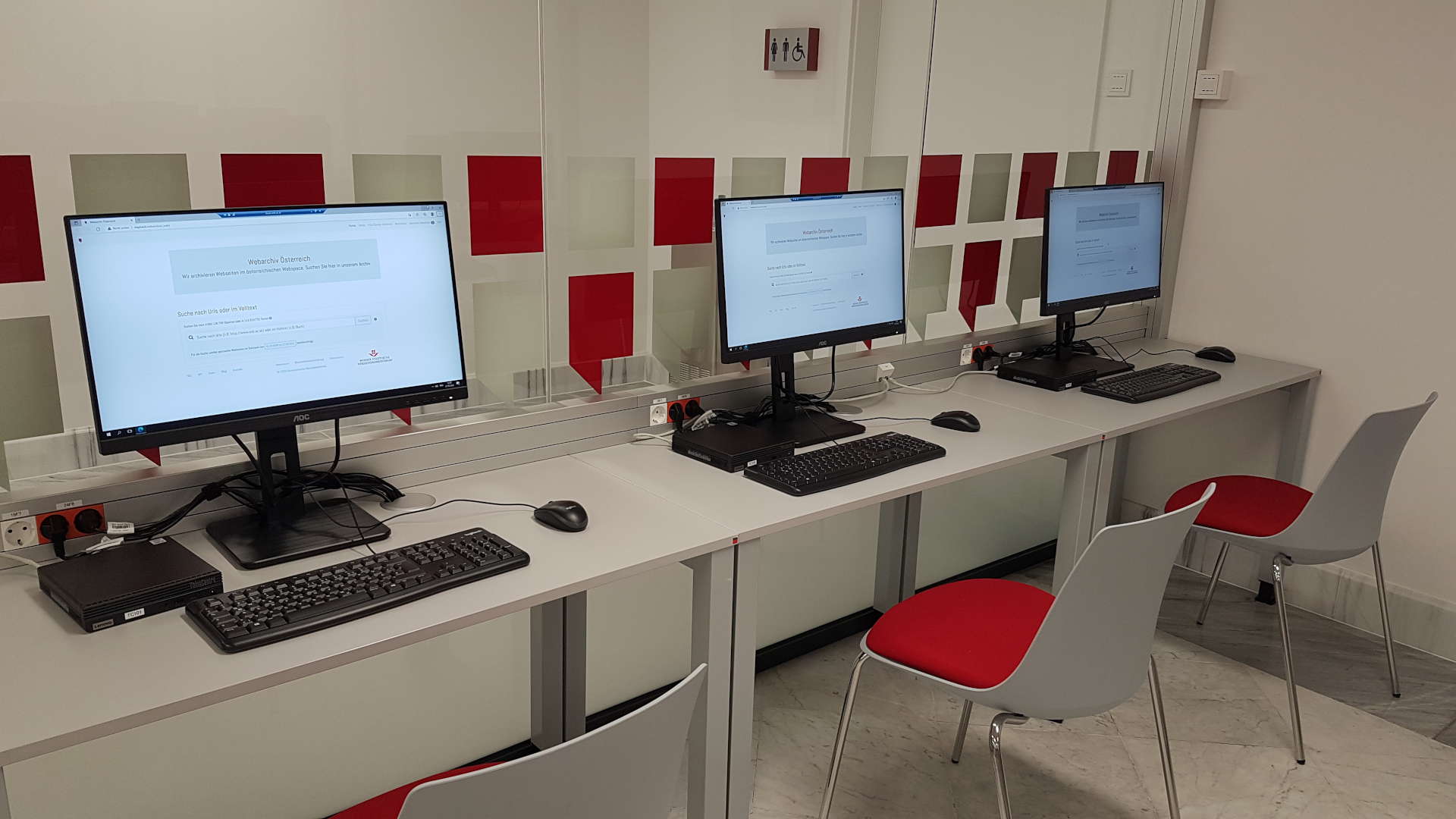

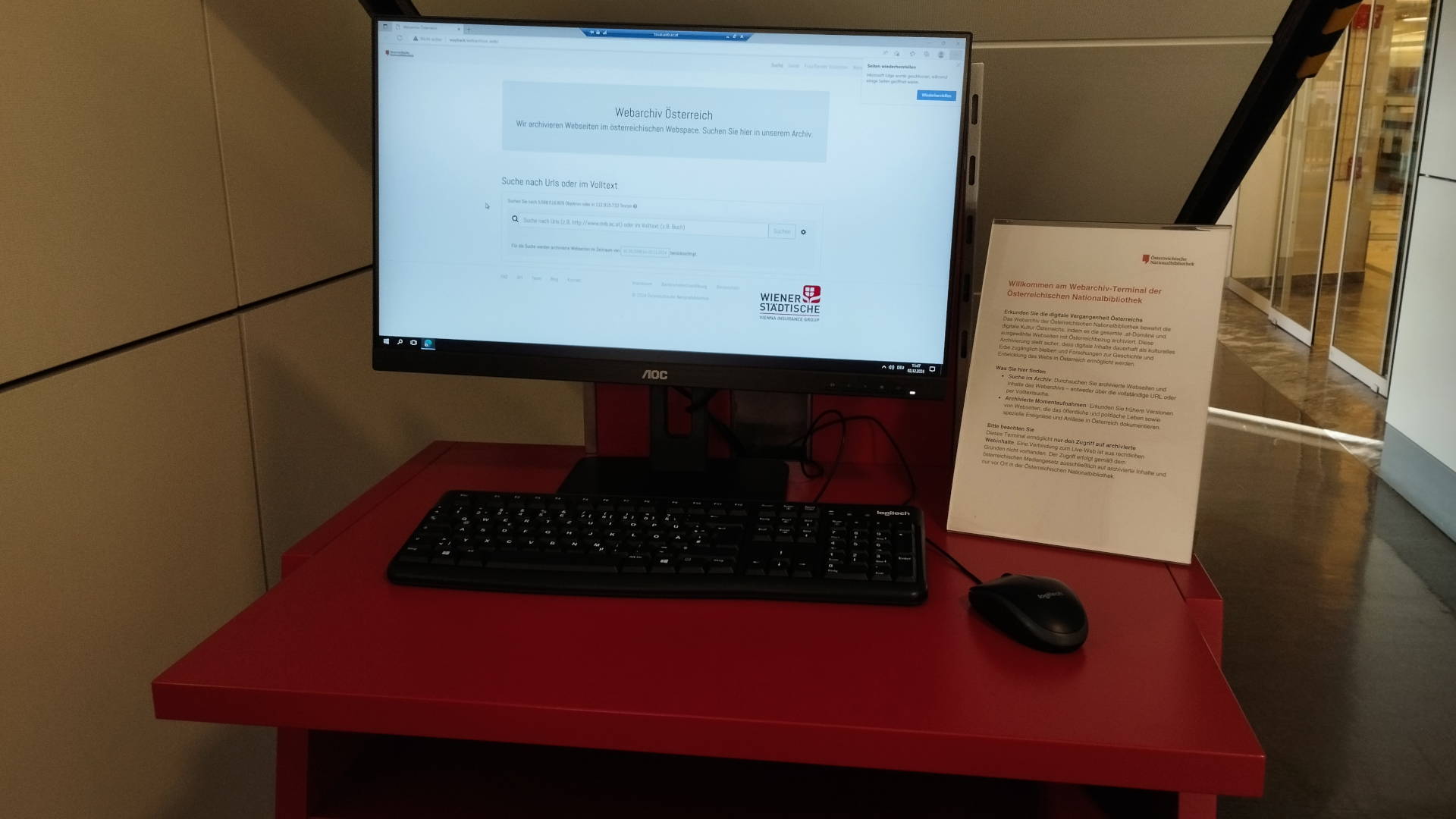

Im Webarchiv der Österreichischen Nationalbibliothek können nur Seiten mit österreichischen Medieninhaber*innen nach Prüfung und Information archiviert werden, da medienrechtliche Vorgaben dies vorschreiben. Nach der Speicherung ist der Zugriff auf diese Seiten jedoch nur vor Ort in den Räumen der Institution möglich – eine Einschränkung, die auch für viele andere europäische Webarchive gilt.4

Wie können archivierte Webressourcen zitiert werden – unabhängig davon, ob sie in offenen oder geschlossenen Archiven gespeichert sind? Hier bietet der Persistent Web Identifier (PWID) eine standardisierte Lösung, um archivierte Inhalte eindeutig und dauerhaft zu referenzieren.

Der Persistent Web Identifier (PWID): Aufbau und Nutzung

Der Persistent Web Identifier (PWID) ist ein standardisierter5, maschinenlesbarer und für Menschen verständlicher Identifier, der archivierte Inhalte eindeutig und dauerhaft referenzieren kann – unabhängig davon, ob sie in offenen oder geschlossenen Archiven gespeichert sind.

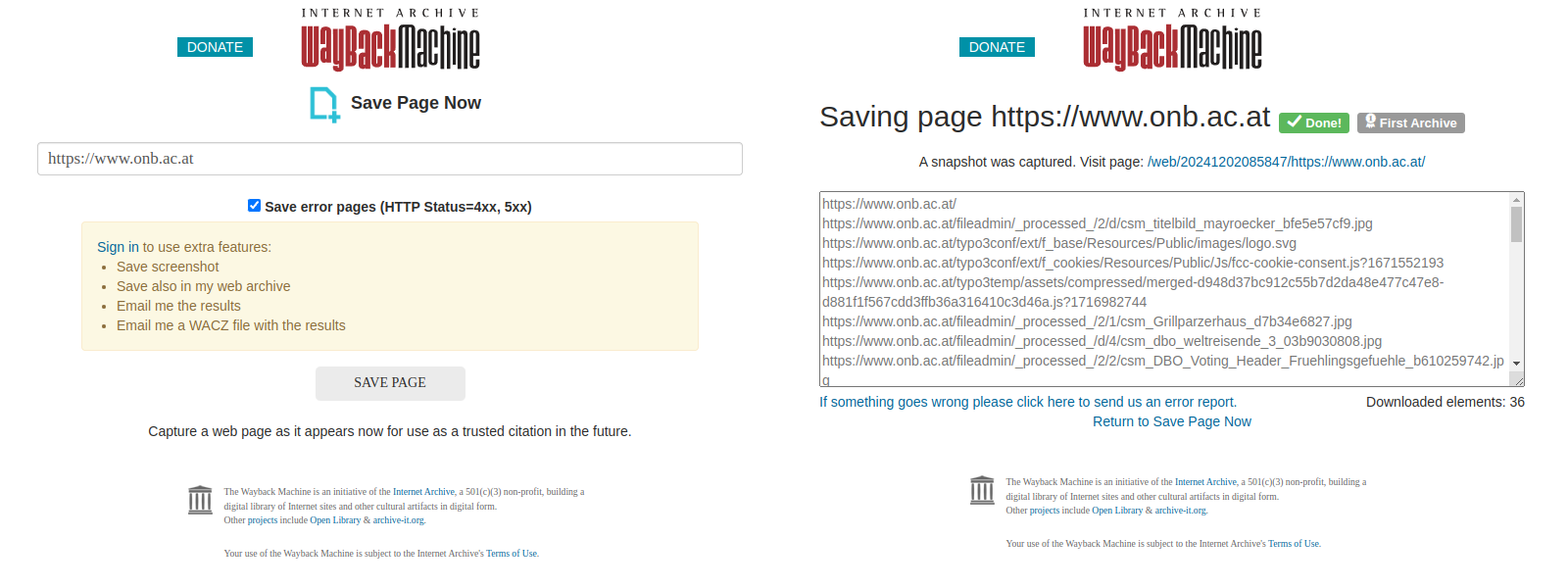

Ein PWID besteht aus mehreren Komponenten, die seine Struktur und Funktionalität bestimmen:

- Präfix: Legt den Namensraum fest, er ist immer urn:pwid

- Webarchiv-Kennung: Identifiziert eindeutig das Webarchiv, in dem die archivierte Webressource gespeichert ist (z.B. webarchiv.onb.ac.at für Webarchiv Österreich)

- Archivierungszeitpunkt: Gibt den Zeitpunkt der Archivierung im UTC-Format an (z.B. 2009-10-22T12:18:32Z)6

- Präzisierung: Gibt an, ob sich der PWID auf eine Einzeldatei (part) oder die gesamte archivierte Website (page) bezieht. Diese Unterscheidung ist besonders nützlich, um entweder einzelne Ressourcen (z. B. Bilder oder Dokumente) oder komplette Websites zu referenzieren.

- Archivierte URL: Die ursprüngliche URL der Website zum Zeitpunkt des Crawls

Beispiel:

urn:pwid:webarchiv.onb.ac.at:2009-10-22T12:18:32Z:page:http://onb.ac.at/prunksaal.htm

PWIDs eignen sich nur für archivierte Websites und lassen sich nicht auf Live-Seiten anwenden. Die Seite muss entweder bereits archiviert oder in einem bestehenden Archiv gefunden werden.

Tools wie der PWID-Generator des Webarchivs Österreich ermöglichen es, eine Archiv-URL automatisch in einen PWID umzuwandeln. Alternativ kann ein PWID auch manuell erstellt werden, indem die fünf Bestandteile (Präfix, Webarchiv-Kennung, Archivierungszeitpunkt, Präzisierung und archivierte URL) entsprechend der oben beschriebenen Struktur kombiniert werden. Die Nutzung des Tools erleichtert diesen Prozess jedoch erheblich.

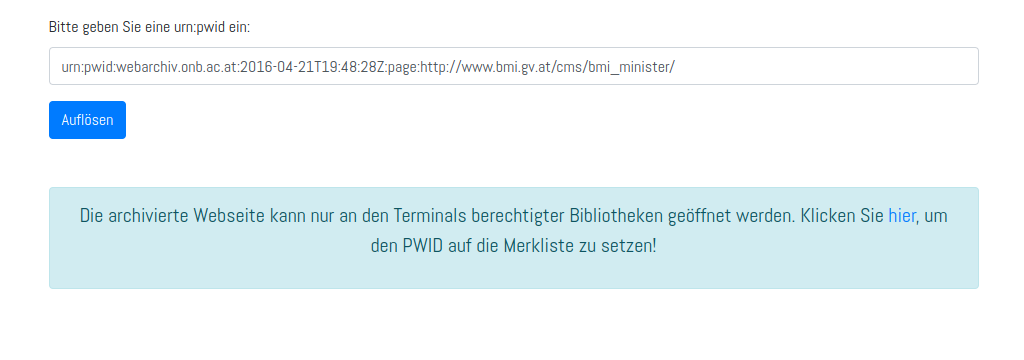

Um einen PWID zu nutzen, kann der PWID-Resolver der Österreichischen Nationalbibliothek verwendet werden. Dieser ist unter https://webarchiv.onb.ac.at/resolve.jsp erreichbar und wandelt einen PWID in die zugehörige Archiv-URL um, auf die anschließend weitergeleitet wird.

Beispiel:

Der PWID urn:pwid:webarchiv.onb.ac.at:2009-10-22T12:18:32Z:page:http://onb.ac.at/prunksaal.htm wird mithilfe des Resolvers in folgende Archiv-URL aufgelöst: https://webarchiv.onb.ac.at/web/20091022121832/http://onb.ac.at/prunksaal.htm

Befindet sich die archivierte Website in einem nicht öffentlich zugänglichen Archiv, stellt der Resolver Informationen bereit, wie der Zugriff erfolgen kann.

Beispiel:

Der PWID urn:pwid:webarchiv.onb.ac.at:2016-04-21T19:48:28Z:page:http://www.bmi.gv.at/cms/bmi_minister/ wird aufgelöst mit dem Hinweis, dass die Seite nur in berechtigten Bibliotheken zugänglich ist. Nutzer*innen können den PWID speichern, um die Seite später in einer Bibliothek aufzurufen.

Um einen PWID zu verlinken kann dieser direkt an die Resolver-URL angehängt werden, z.B.: https://webarchiv.onb.ac.at/resolve.jsp?pwid=urn:pwid:webarchiv.onb.ac.at:2009-10-22T12:18:32Z:page:http://onb.ac.at/prunksaal.htm

Der PWID-Resolver der Österreichischen Nationalbibliothek unterstützt derzeit das Webarchiv Österreich, das Internet Archive, das Portugiesische Webarchiv und das Isländische Webarchiv. Ein universeller Resolver für alle Webarchive steht bisher nicht zur Verfügung. Diese Aufgabe könnte künftig vom International Internet Preservation Consortium (IIPC)7 übernommen werden. Erste Vorarbeiten dafür sind bereits im Gange. Bis dahin bietet der Resolver der Österreichischen Nationalbibliothek eine zuverlässige Möglichkeit, PWIDs aufzulösen.

Wer langfristige Quellenangaben für Webinhalte sicherstellen will, sollte die Möglichkeiten von Webarchiven nutzen. Ein PWID bietet aktuell die zuverlässigste Methode, um archivierte Websites eindeutig und dauerhaft zu zitieren. Ist dies zu komplex, empfiehlt es sich zumindest, eine Archiv-URL anstelle einer Live-URL zu verwenden. Sowohl Archiv-Links als auch PWIDs haben eine höhere Überlebenschance. Der PWID bietet zusätzlich die Möglichkeit, archivierte Inhalte standardisiert und maschinenlesbar zu referenzieren, was ihn zur bevorzugten Methode für langfristige Zitationen macht.

Die Österreichische Nationalbibliothek bedankt sich sehr herzlich bei der Wiener Städtischen Versicherung für die Unterstützung des Webarchivs Österreich.

Über den Autor: Mag. Andreas Predikaka ist technisch Verantwortlicher des Webarchivs Österreich an der Österreichischen Nationalbibliothek.

Fußnoten:

1 Vgl. Brügger, Niels (2018): The Archived Web. Doing History in the Digital Age, Cambridge London: The MIT Press, 87

3 Das Internet Archive auf https://web.archive.org/save und das Portugiesische Webarchiv auf https://arquivo.pt/services/savepagenow?l=en bieten Dienste an, mit denen Live-Webseiten auf Knopfdruck archiviert werden können. Der nach dem Archivierungsvorgang generierte Archiv-Link kann anschließend mithilfe des PWID-Generators des Webarchivs Österreich auf https://webarchiv.onb.ac.at#pwid in einen weiter verwendbaren PWID umgewandelt werden.

4 Für die Nutzung des Webarchivs stehen spezielle Terminals im CIM (Center für Information und Medienkompetenz) im Tiefparterre der Österreichischen Nationalbibliothek zur Verfügung. Die Öffnungszeiten sind montags bis freitags von 9:00 bis 21:00 Uhr. Vor Ort erhalten Nutzer:innen Unterstützung bei der Großformatebuchausgabe.

5 Die für Verwaltung und Registrierung von URN-Namensräume zuständige IANA (Internet Assigned Numbers Authority) genehmigte 2022 den PWID. Vgl. urn:pwid:archive.org:2022-11-27T18:33:21Z:page:https://www.iana.org/assignments/urn-formal/pwid

6 UTC ist unabhängig von Zeitzonen und gewährleistet eine einheitliche Zeitangabe für archivierte Inhalte weltweit. Ein Timestamp wie 2009-10-22T12:18:32Z folgt dem ISO-8601-Standard und gibt den Zeitpunkt der Archivierung in UTC (Koordinierter Weltzeit) an. Der Buchstabe 'T' trennt das Datum (2009-10-22) von der Uhrzeit (12:18:32), während das 'Z' am Ende für 'Zulu Time' steht - eine standardisierte Kennzeichnung für die UTC-Zeit. Vgl. urn:pwid:archive.org:2024-06-22T22:44:02Z:page:https://de.wikipedia.org/wiki/Koordinierte_Weltzeit

7 Das International Internet Preservation Consortium (IIPC) ist ein internationales Netzwerk von Bibliotheken, Archiven und anderen Institutionen, das 2003 gegründet wurde. Ziel des Konsortiums ist es, Technologien, Standards und bewährte Verfahren zur Erhaltung und Archivierung von Webinhalten zu entwickeln und zu fördern. Vgl. urn:pwid:archive.org:2024-06-18T04:13:28Z:part:https://de.wikipedia.org/wiki/International_Internet_Preservation_Consortium

Browsertrix-Crawling-Profile

Autor: Antares Reich

Wie funktionieren Webcrawls bei passwortgeschützten Inhalten, z.B. Medienportalen oder Social Media?

Durch aktuelle Umbrüche in der allgemeinen Kommunikation und im Publikationswesen werden Online-Inhalte verstärkt in passwortgeschützte Bereiche von Websites verlagert. Dies betrifft vor allem Social Media und Medienportale, die ihre Inhalte vermehrt kostenpflichtig hinter sogenannten Paywalls anbieten. Webarchive müssen auf diese Veränderungen reagieren, indem sie neue Crawlertechnologien einsetzen.

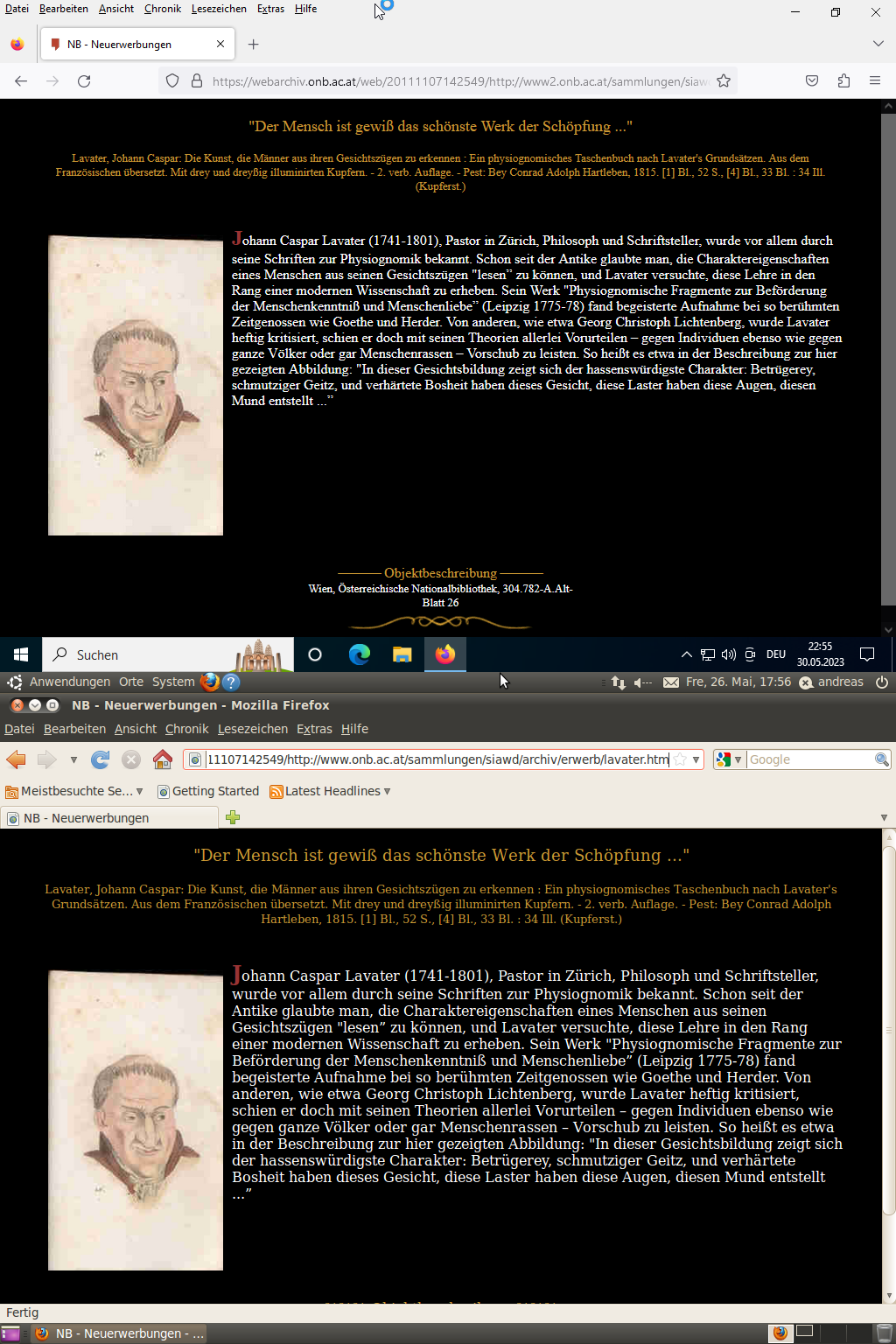

Dieser Artikel ist die Fortsetzung des letzten Blogbeitrags aus dem Webarchiv: "Browserbasiertes Crawling. Die Evolution des Webs"1, in dem der Browsertrix Crawler und die Browsertrix Profile vorgestellt werden. Ein Browsertrix Profile ist ein Startpunkt für einen Crawl, es speichert Sitzungsinformationen wie Cookies und kann verwendet werden, um eine Website als eingeloggte*r Benutzer*in zu archivieren. Auf vielen Websites wird der Inhalt nur für eingeloggte Benutzer*innen vollständig angezeigt. Daher ist es für ein Webarchiv sehr wichtig, dass man während des Archivierungsprozesses eingeloggt ist, um an den gesamten Inhalt zu gelangen. In einem Webarchiv laufen sehr viele Crawler parallel und deswegen war es erforderlich, das Profil-Handling zu automatisieren.

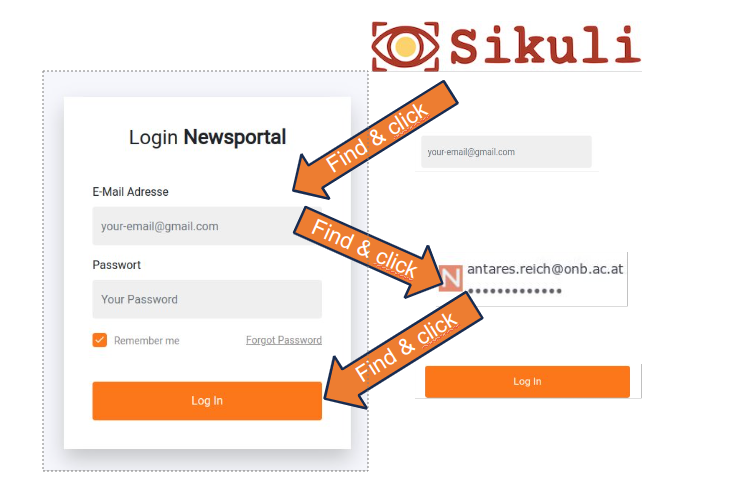

Das Titelbild zeigt den Ablauf, um die im Browser gespeicherten Nutzer*innen-Daten (Name und Passwort) für einen Login zu verwenden. Voraussetzung dafür ist, dass die Login-Informationen zuvor im Browser gespeichert wurden. Wenn auf einer Website mit hinterlegten Login-Informationen das E-Mail-Feld angeklickt wird, zeigt der Browser ein Drop-Down mit dem, mit einem einzigen Klick, die Login-Informationen in dem Formular eingetragen werden. Genau diese Schritte – von Website aufrufen, das Login Feld anklicken, die gespeicherten Login Daten aufrufen und schließlich den Login Button zu klicken – sollten von einem Programm automatisch durchgeführt werden.

Beschränkungen für Browsertrix-Crawling-Profile

Vor Betrachtung der gesamten Prozesskette ist es wichtig, auch die Einschränkungen und Probleme für eingeloggte Profile zu kennen:

1. Sitzungen/Cookies haben ein Enddatum und werden automatisch beendet, wenn dieses Datum überschritten ist.

2. Websites werden laufend überarbeitet bzw. aktualisiert und Sessions können dadurch ungültig werden.

3. Bot-Detektion-Tools können den Zugriff auf Websites automatisiert beschränken.

Automatisierung für Browsertrix-Crawling-Profile

Es gibt viele Ansätze, wie die Erstellung von Browsertrix-Profilen automatisiert werden kann, einer wird sogar vom Browsertrix-Crawler selbst geliefert: Die Automatisierte Profilerstellung für die Benutzeranmeldung2.

Aber aus einigen Gründen, z.B. wenn Websites durch Cookie-Consent-Boxen blockiert werden, haben wir uns dazu entschlossen, unser eigenes automatisiertes System zu entwickeln und verwenden dafür die folgenden Technologien:

- Selenium - Ein Testautomatisierungs-Framework3

- Sikuli API - Ein Framework zur Bilderkennung4

- Xvfb - Bildschirmvirtualisierungsanwendung für Headless-Anwendungen

Menschliche Interaktion

Um besser verstehen zu können, was die Automatisierung genau bringt, wollen wir die Interaktionen nachvollziehen, die für die Wartung der Browser-Profile bisher notwendig waren. Das Profile-Validierungsprogramm ist schon seit Mitte 2023 im Einsatz und hatte bereits ursprünglich die Aufgabe, zu erkennen, wenn ein Profil invalide wurde und anschließend eine Benachrichtigung per E-Mail zu senden, welches Profil invalide wurde. Dieses Programm startet nun stattdessen ein eigenes Software-Programm (Reinit, siehe unten Automatisierungskette, Schritt 3). Zum neuen Initialisieren des Profils mussten bisher zahlreiche aufwändige manuelle Schritte ausgeführt werden.

Headless Mode – ohne Kopf? Ohne Bildschirm!

Da ein Crawler auf einem Server läuft, hat er in der Regel keine Bildschirme angeschlossen. Das gleiche gilt für andere Ein-/Ausgabegeräte wie Maus oder Tastatur. In der IT wird ein solches Gerät “Headless” genannt. Dies ist normalerweise nicht erwähnenswert, aber in unserem Fall, wenn die menschliche Interaktion mit einer Webapplikation durch ein Programm ersetzt wird, muss diese Interaktion auf dem nicht vorhandenen Bildschirm gelöst werden. Es muss also ein virtueller Bildschirm gestartet werden, bevor die anderen Komponenten so arbeiten können, wie sie sollen. Dazu mussten auf den jeweiligen Websites Bildbereiche, mit denen interagiert werden soll, mit einem Screenshot Tool ausgeschnitten werden, wie zum Beispiel das Login-Feld oder ein Akzeptieren-Button. Diese kleinen Bildausschnitte müssen von Sikuli auf dem virtuellen Monitor gefunden, quasi “gesehen”, werden können.

Erwähnenswert ist, dass auch auf einem virtualisierten Bildschirm die Bildschirmauflösung und die Farbtiefe eine gravierende Rolle spielen und es wichtig ist, die gleiche Farbtiefe auf dem (realen) Bildschirm zu verwenden, auf dem die Bilder vorbereitet werden, wie auf dem virtuellen Bildschirm, auf dem diese Bilder gesucht und angeklickt werden.

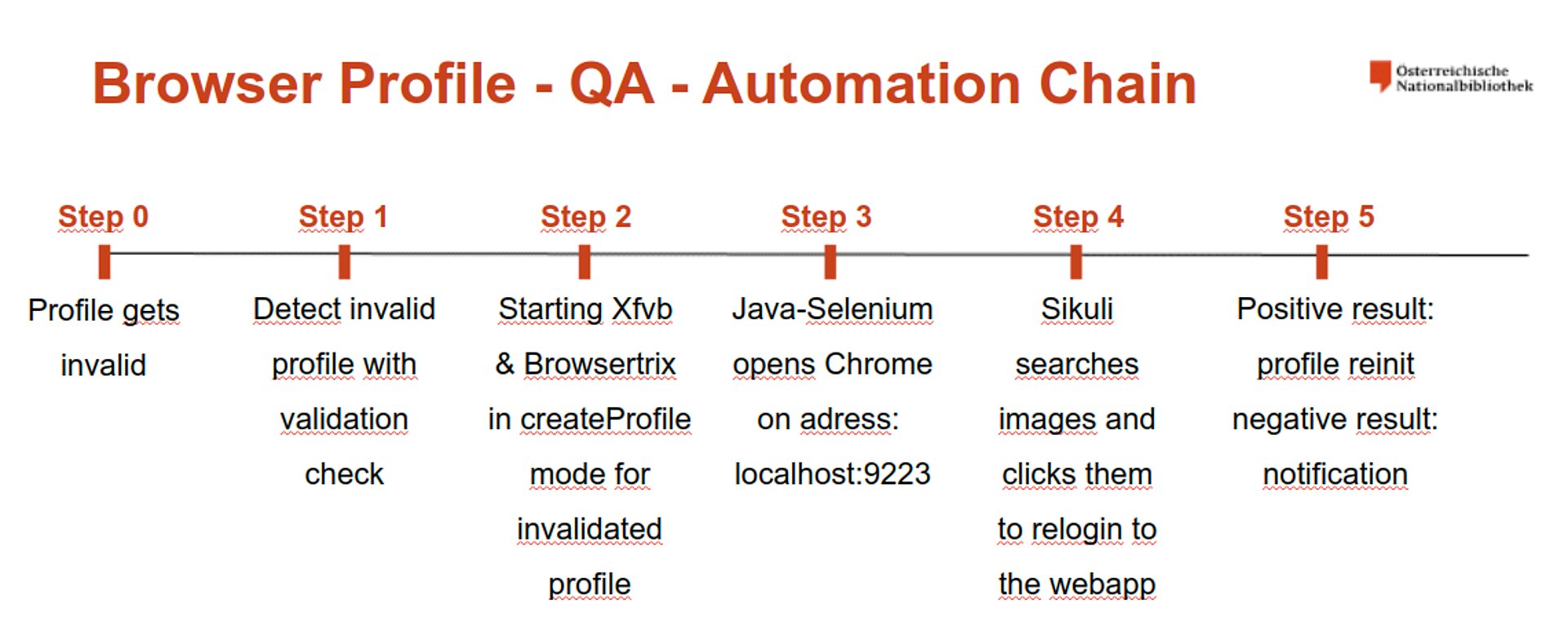

Die Automatisierungskette

Die gesamte Automatisierungskette reicht von der Profilvalidierung bis zur Neuinitialisierung des Profils und wird in der folgenden Abbildung mit allen notwendigen Schritten beschrieben.

Schritt 0: Profil wird invalide

Dieser Schritt ist passiv und passiert nicht zwingend zur Laufzeit eines Crawls; er wird nur durch die Session und Cookie Definitionen der Website, die archiviert werden soll, gesteuert.

Schritt 1: Profilvalidierung

Diese Aufgabe hat nur ein Ziel: zu überprüfen, ob das Profil noch angemeldet ist. Dazu wird eine tiefenlose Archivierung (siehe Crawling – Scope letzter Beitrag, Tiefe 0 in diesem Fall) einer Seite hinter dem Login durchgeführt. Wenn die Seite archiviert wurde, wird der Inhalt des WARC-Files analysiert und wenn der Crawler z.B. zum Login-Formular umgeleitet wurde oder ein bestimmtes Muster wie der spezifische Benutzername oder die E-Mail-Adresse nicht erfasst wurde, wird das Profil als ungültig markiert.

Schritt 2: Vorbereitungen zur Re-Initialisierung

Auf der Crawling-Maschine, die das spezifische Browser-Profil verwendet, wird nun der virtuelle Monitor mit Xfvb und der Browsertrix-Crawler im createProfile-Modus gestartet, der eine mit einem Browser aufrufbare Schnittstelle öffnet.

Schritt 3: Starten des Reinit-Programms

Als nächstes wird das Reinit-Java-Programm gestartet. Es wird etwas verzögert gestartet, um Browsertrix Zeit zu geben, die Verbindung zu öffnen. Das Java-Programm öffnet Chrome mit Selenium (um den Browser durch das Java Programm interaktiv zu machen) und geht an die createProfile Adresse auf dem Localhost.

Schritt 4: Die Magie von Sikuli

Nach der Navigation zu einem Anmeldeformular startet Sikuli und sucht auf dem Bildschirm nach Bildern. Wenn das gesuchte Bild gefunden wird, klickt Sikuli darauf oder interagiert mit dem Formular über die Tastatur. Die Fehlerbedingung ist, dass am Ende des automatischen Anmeldevorgangs ein Verifizierungsbild hinter dem Login gefunden werden muss (meistens das eigene Profil-Bild).

Schritt 5: Prozess Abschluss – neues Profil oder Benachrichtigung

Wenn Sikuli das Verifizierungsbild nicht finden kann, wird das gesamte Java-Programm als fehlgeschlagen zurückgegeben und eine Benachrichtigung gesendet. Falls Sikuli das Verifizierungsbild im Login-Bereich einer Website finden kann, speichert das Programm den Status der Sitzung in einem neuen Browsertrix-Profil und kopiert es nach der Rückkehr des Java-Prozesses an die richtige Stelle, um es beim nächsten geplanten Crawl zu verwenden.

Unser bestehender Workflow wurde auf der IIPC-Web-Archiving-Conference 2024 in Paris im Workshop “Unlocking Access: Navigating Paywalls and Ensuring Quality in Web Crawling” vorgestellt und wird dieses Jahr auch auf dem Videoportal YouTube veröffentlicht.

Die Österreichische Nationalbibliothek bedankt sich sehr herzlich bei der Wiener Städtischen Versicherung für die Unterstützung des Webarchivs Österreich.

Über den Autor: Antares Reich ist Crawl Engineer des Webarchivs Österreich an der Österreichischen Nationalbibliothek.

Fußnoten:

1 Reich, Antares (2023): "Browser Based Crawling. Die Evolution des Webs", [Online] https://www.onb.ac.at/mehr/blogs/detail/browser-based-crawling-die-evolution-des-webs [15.6.2024]

2 Entwicklungsprojekt Browsertrix Crawler auf GitHub, [Online] https://github.com/webrecorder/browsertrix-crawler [15.6.2024]

3 Selenium automatisiert Browser, [Online] https://www.selenium.dev/ [15.6.2024]

4 Raimund Hocke SikuliX, [Online] https://web.archive.org/web/20240217083947/http://sikulix.com/ [15.6.2024]

Browser Based Crawling. Die Evolution des Webs

Autor: Antares Reich

Das Webarchiv Österreich ist Teil einer internationalen Gemeinschaft, dem International Internet Preservation Consortium (IIPC)1. Neben jährlichen Konferenzen, Schulungen und Diskussionen werden durch die IIPC auch Projekte finanziert. Dazu zählt etwa der Browsertrix Crawler inklusive einer Management Oberfläche der Browsertrix Cloud.2

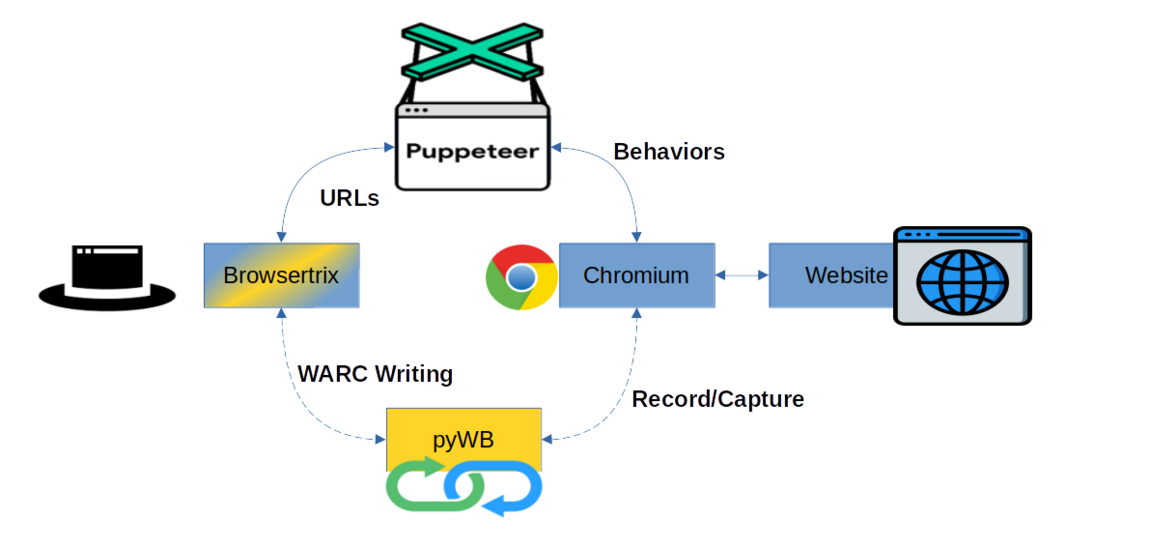

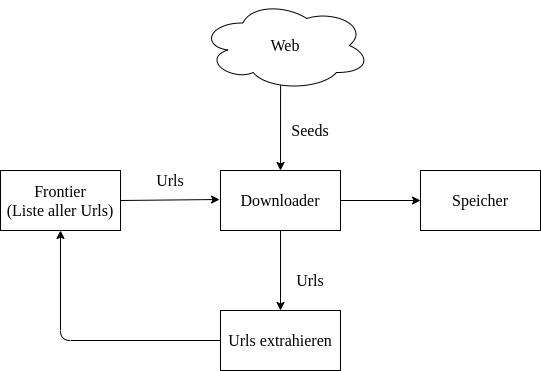

In den letzten Jahren hat sich eine neue Generation an Programmen zum Archivieren des Webs etabliert und damit auch ein neuer Begriff: "Browser Based Crawling". Wobei "Crawling" das automatisierte "Ernten" von Webseiten bezeichnet, also das Sichern von Websiten in einem Archivformat (ARC, WARC, WACZ)3. Archivformate können durch andere Software wieder gelesen und in einem Webbrowser zur Darstellung gebracht werden. Im österreichischen Webarchiv sichern wir aktuell im WARC-Format, zum Darstellen unserer Archiv Dateien benutzen wir die Wayback Machine4 des Internet-Archives. Um Websites korrekt archivieren zu können ist es von fundamentaler Bedeutung, dass die Erntesoftware, der sogenannte Crawler, mit der zu archivierende Website erfolgreich interagieren kann. Auch der Mensch muss mit einer Website in Interaktion treten, um an die gesuchten Inhalte zu gelangen. Jede*r von uns macht dies alltäglich und nutzt dazu eine spezielle Software: einen Webbrowser. Dies ist seit Beginn des Webs so, doch wurden damals noch (meist) pure HTML/CSS/Javascript Dateien durch den Browser interpretiert. Moderne Websites, aber auch die Browser selbst, wurden seither immer komplexer. Zum einen werden Seiten dynamisch generiert, also große Teile der Inhalte aus Datenbanken erstellt. Zum anderen werden die HTML-Elemente der Websites immer rudimentärer und die tatsächlich sichtbare Seite durch interaktive Veränderung der Inhalte durch Skripte erstellt. Sowohl die Interpretation, als auch die Ausführung dieser Skripte findet im Browser statt.

Browser Based Crawler - Browsertrix

Es existiert bereits eine Vielzahl an Archivierungssoftware die sich selbst als "Browser Based" bezeichnet. Für das österreichische Web hat sich Browsertrix als Crawler der Wahl herausgestellt, der im Folgenden näher beschreiben wird.

Diese Technologie arbeitet genauso wie ein*e menschliche*r Websitennutzer*in. Der Crawler öffnet einen Browser, wie etwa Chrome oder Firefox, und besucht eine Website. Dann beginnt er weitere Links zu extrahieren, um anschließend auf den gesamten Inhalt der geladenen Seite, wie Text, Bilder, Videos und Buttons zu klicken und ihn nachzuverfolgen. Dies erfolgt mit Skripten, die direkt im Browser des Crawlers ausgeführt werden: die sogenannten "Behaviour" (Verhaltensweisen). Behaviour für Browsertrix werden mittels der Puppeteer Bibliothek5 ausgeführt und können sowohl angepasst als auch grundsätzlich selbst geschrieben werden. Dies ermöglicht es dem Crawler für unterschiedliche Websites unterschiedliche seitenspezifische Verhaltensweisen auszuführen, wodurch eine nahezu perfekte Qualität einer archivierten Website erreicht werden könnte. Der Konjunktiv ist wichtig, weil es mit erheblichem Aufwand verbunden ist, große Websites vollständig zu analysieren, zu archivieren und die Qualitätskontrolle des Archivs durchzuführen. Deshalb wird in der Praxis kaum eine Website vollständig archiviert. Es werden zu Beginn eines Crawls immer Grenzen festgelegt, in der Webarchivierung wird dies als "Scope" bezeichnet. Diese Grenzen können entweder Speicherplatz, Anzahl der Seiten/Objekte oder die Ausführungszeit sein. Beim Erreichen eines dieser festgelegten Limits wird der Crawl beendet und Inhalte, die über diese Grenze hinausgehen, werden nicht mehr archiviert. Weiters definiert der Scope auch, wie mit Verlinkungen auf externe Websites umgegangen wird. So kann hier z.B. festgelegt werden, wie viele Ebenen der Verlinkung vom Crawler mitarchiviert werden, oder ob externe Links nach bestimmten Schlagworten durchsucht und archiviert werden sollen. Es könnte auch ein physikalischer Server als Scope angegeben werden, und so alle Ressourcen, die dort gefunden werden, archiviert werden. Zwei weitere wichtige Einstellungen gehören zum Scope: Die Anzahl an Sprüngen außerhalb der definierten Grenzen und in welche Tiefe die Seite gecrawlt wird, was der Anzahl von Klicks von der Ausgangsseite entspricht. Es wird daraus klar, dass das Einstellen eines Crawls sich schnell zu einer komplexen Angelegenheit entwickeln kann.6

Qualitätssteigerung durch den Einsatz von Browsertrix anhand der Website der Österreichischen Nationalbibliothek

Die Funktionsweise von Browsertrix

Ein modernder Crawler muss die folgenden drei Aufgaben erfüllen

- Links auf Websites auslesen und je nach Scope ihnen folgen oder sie verwerfen.

- Jeden Link der Seite in einem Browser aufrufen und in Interaktion treten.

- Die Inhalte in einem Archivformat speichern.

Der letzte Punkt, das Archivieren, erfolgt aktuell im Browsertrix durch die python Wayback (pyWB). Diese wurde entwickelt, um die Open Wayback Machine des Internetarchivs zu erneuern. Im Unterschied zur Open Wayback kann die pyWB auch in einem Aufzeichnungs-Modus gestartet werden, der bewirkt, dass alle Seiten, auf die navigiert und mit denen interagiert wird, in einem Archivformat gespeichert werden. Genau dies passiert auch innerhalb der Browsertrix Applikation. Seiten werden geladen und mittels Behaviours in Interaktion gesetzt, gleichzeitig wird mittels pyWB in einem Archivformat gesichert.

Browser Based Crawler hinter Logins und Paywalls

Einige Websites haben absichtlich zusätzliche Hindernisse eingebaut, die erst überwunden werden müssen, bevor der Inhalt der Seite zur Anzeige gebracht werden kann. Zum Beispiel müssen Benutzer*innen zunächst die Seitenrichtlinien und Cookies akzeptieren, oder es müssen Browser Plugins, die Werbung blockieren, für spezielle Websites deaktiviert werden. Manche Webinhalte sind kommerziell und werden nur zahlenden Nutzer*innen angezeigt, in diesem Fall wird von Paywalls gesprochen. Auch diese Hindernisse können mit dem Einsatz von Browsertrix, genauer gesagt mit Browsertrix Profilen, überwunden werden. Diese Profile werden vor dem Crawl seitenspezifisch erstellt, indem z.B. ein Login auf der Seite durchgeführt wird. In Profilen ist also der Ausgangspunkt des Crawls gespeichert. Wird ein Profil zum Start des Crawls geladen, fährt der Crawler an der Stelle fort, wo das Profil geendet hat, also z.B.: nach dem Login, und kann so direkt als eingeloggte*r User*in seinen Archivierungsprozess starten. Der größte Nachteil dieser Methode ist, dass die Sitzungen nur eine gewisse Gültigkeitsdauer haben und je nach Seite von Zeit zu Zeit überprüft und gegebenenfalls erneuert werden müssen.

Die Österreichische Nationalbibliothek bedankt sich sehr herzlich beim Wiener Städtische Versicherungsverein für die Unterstützung des Webarchivs Österreich.

Über den Autor: Antares Reich ist Crawl Engineer des Webarchivs Österreich an der Österreichischen Nationalbibliothek.

Fußnoten

1 Mehr Informationen siehe IIPC Webseite [Online]: https://netpreserve.org/ [7.11.2023]

2 Mehr Informationen zum Projekt bei IIPC: “BROWSER-BASED CRAWLING SYSTEM FOR ALL” [Online] https://netpreserve.org/projects/browser-based-crawling [6.11.2023] sowie dem Entwicklungsprojekt Browsertrix Crawler auf GitHub [Online] https://github.com/webrecorder/browsertrix-crawler [6.11.2023]

3 Das einzige Archivformat, dass ISO-Standardisiert wurde (ISO 28500:2017) ist das WARC-Format. Nähere Informationen siehe IIPC: ”The WARC Format 1.1” [Online] https://iipc.github.io/warc-specifications/specifications/warc-format/warc-1.1/ [6.11.2023]

4 Aktive Openway Back Machine im Einsatz: Internetarchiv https://archive.org/web/ und im spezifischen für das Österreichische Webarchiv https://webarchiv.onb.ac.at/ und zu näheren Erläuterungen siehe auch Predikaka, Andreas (2020): “Wie das archivierte österreichische Web wieder auf den Bildschirm kommt”, [Online] https://www.onb.ac.at/mehr/blogs/detail/wie-das-archivierte-oesterreichische-web-wieder-auf-den-bildschirm-kommt-3 [6.11.2023]

5 Projektbeschreibung Puppeteer siehe https://pptr.dev/ [6.11.2023]

6 Vgl. Predikaka, Andreas (2020): “Wie das österreichische Web im Archiv landet”, [Online] https://www.onb.ac.at/mehr/blogs/detail/wie-das-oesterreichische-web-im-archiv-landet-3 [6.11.2023]

Vom Scannen bis zur Webarchivierung: Emulation und Migration als Schlüssel zur Langzeitarchivierung

Autor*innen: Karin Heide BA, Mag. Andreas Predikaka

"‘Langzeit‘ bedeutet für die Bestandserhaltung digitaler Ressourcen nicht die Abgabe einer Garantieerklärung über fünf oder fünfzig Jahre, sondern die verantwortliche Entwicklung von Strategien, die den beständigen, vom Informationsmarkt verursachten Wandel bewältigen können.“ 1

Digitale Langzeitarchivierung - Ein interdisziplinäres Projekt

Die Anfänge der digitalen Langzeitarchivierung (LZA) liegen nun bereits mehr als ein halbes Jahrhundert zurück4/ und sind eng verbunden mit der Entwicklung der elektronischen Datenverarbeitung in den späten 1960er und frühen 1970er Jahren. Ab den 1980er Jahren lieferte vor allem die Raumfahrtforschung wesentliche Impulse zur Verwaltung und Bereitstellung großer Datenmengen.3

Die Entwicklung des Internets und das damit verbundene Aufkommen neuer elektronischer Publikationsstrukturen ab den 1990er Jahren führte schließlich dazu, dass sich auch die Bibliotheks- und Archivwissenschaften verstärkt mit dem Thema der digitalen LZA auseinanderzusetzen begannen. Die Entwicklung internationaler Standards und einer Terminologie für digitale Objekte und die mit ihnen assoziierten Metadaten ist eine Folge dieser interdisziplinären Zusammenarbeit. Auch die Entwicklung des Open Archival Information System (OAIS) als international anerkanntes funktionales Referenzsystem fällt in diesen Zeitraum.4

Weltweit setzen sich Bibliotheken, Archive, Gedächtnis- und Forschungsinstitutionen also bereits seit mehreren Jahrzehnten theoretisch und praktisch mit dem Thema der digitalen LZA auseinander. Und auch im Allgemeinverständnis ist der Begriff der Backup-Kopie längst angekommen. Es stellt sich also die Frage:

Wozu eine Begriffsklärung?

Das komplexe Feld der digitalen LZA gliedert sich in zwei große Aufgabenbereiche:

- Sicherung der Daten

- Erhaltung des Zugriffs und der Nutzbarkeit der Daten

Die nestor-Arbeitsgruppe Standards für Metadaten schreibt dazu, dass "Daten […] aus üblicherweise heterogenen technischen und organisatorischen Kontexten so übernommen werden [müssen], dass sie trotzdem in ganz anderen, zukünftigen Kontexten verstehbar und nutzbar sein werden.“5

Die hier unter Punkt 1 angeführte „Sicherung der Daten“ wird als Bitstream Preservation bezeichnet und meint das, was allgemein unter Archivkopie oder Backup verstanden wird. Für ein präziseres Verständnis der großen Herausforderung, mit der alle langzeitarchivierenden Institutionen konfrontiert sind, ist es notwendig, sich den Punkt 2 der Aufgabenbereiche näher anzusehen.

Im Sinne einer Begriffsklärung lässt sich sagen:

Digitale LZA muss sich nicht nur mit der Sicherung der Datenströme, sondern auch mit der Sicherung des Zugriffs (Access) und somit mit allen denkbaren zukünftigen Nachnutzungsszenarien auseinandersetzen.

Was ist das Problem?

Letztlich umreißt bereits der Begriff „Datenstrom“ (Bitstream) worum es in bei der Konzeption und praktischen Umsetzung eines vertrauenswürdigen digitalen Langzeitarchivs6 gehen muss:

Im Gegensatz zu "klassischen" Medien reicht es nicht aus, die Datenträger zu erhalten. Technische Systeme und Konzepte sind erforderlich, um die Daten zu interpretieren. Digitale Informationen veralten mit der Umgebung, in der sie erstellt wurden. Daraus ergeben sich Abhängigkeiten von

- Hardware und Speichermedien

- Betriebssystemen

- Applikationen UND

- Kontextinformationen (Metadaten)

In der digitalen LZA haben sich aus diesem Grund zwei Konzepte ergeben:

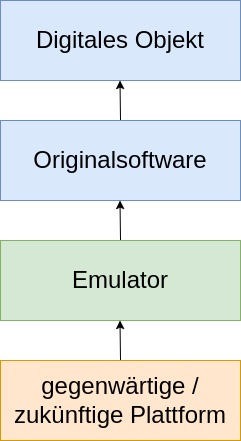

Emulation

In diesem Ansatz verhalten sich zukünftige Technologien wie die Originalumgebung des digitalen Objekts. Der Originaldatenstrom kann in ursprünglicher Form zugänglich gemacht werden. Der Nachteil: Diese Methode ist sehr aufwändig, da auch die Emulationsumgebung ständig an neue Umgebungen angepasst werden muss.

Migration, Vertrauenswürdigkeit und Authentizität

Bei der Migration handelt es sich um die Transformation eines digitalen Objekts in anderes Format, um der sogenannten Formatobsoleszenz vorzubeugen. Dabei wird das Objekt verändert und an seine neue Umgebung angepasst, um zukünftigen (sich ebenfalls verändernden) Nutzungsansprüchen gerecht zu werden. Diese Methode ist aufgrund ihrer – im Vergleich zur Emulation – „einfacheren“ Umsetzbarkeit in der aktuellen LZA weiter verbreitet. Der Nachteil wurde bereits angesprochen: Digitale Dateien (Originale) werden im Laufe der Zeit transformiert / verändert.

Aus archivarischer Sicht müssen aus diesem Grund Fragen nach der Authentizität des digitalen Objektes sowie einer engmaschigen Qualitätskontrolle (Identifizierung / Validierung) in den Blick genommen werden.

„Prinzipiell kann man nie genug über eine archivierte Datei wissen“7

In der digitalen Langzeitarchivierung spielen deshalb die Formatidentifizierung und anschließende Validierung eine entscheidende Rolle. Das korrekte Identifizieren und Kategorisieren von Dateiformaten sind von großer Bedeutung, um langfristig Authentizität, eine sichere Aufbewahrung und Zugänglichkeit von digitalen Dokumenten und Daten zu gewährleisten.

Wie funktioniert die Identifizierung von Dateiformaten?

Ein erstes wichtiges Merkmal ist die Dateiendung. Eine Buchstabenkombination am Ende des Dateinamens, zum Beispiel “.jpg” für eine Bilddatei oder “.pdf” für ein PDF-Dokument. Die Dateiendung kann einen Hinweis auf das Format geben, ist aber nicht immer zuverlässig, da sie leicht geändert oder falsch angegeben werden kann.

Aus diesem Grund erfolgt die Erkennung des Dateiformates aufgrund spezifischer Merkmale und Muster die sich auf Code-Ebene in der Datei befinden. Diese eindeutigen Muster von Dateiformaten werden auch „Signaturen“ genannt und sind in einer internationalen Datenbank hinterlegt. Das Dateiformatregister PRONOM8 wird von den National Archives in England gepflegt und kann dort mit den passenden Tools abgefragt werden.

Qualitätskontrolle und ihre Konsequenzen

So komplex die Abläufe dieser systemimmanenten Prozesse im Detail sind, so nachvollziehbar sind in vielen Workflowmodellen (Preservation plans) die Konsequenzen einer fehlerhaften Formatidentifizierung und -validierung.

Beispiele:

1) Online Bereitstellung einer digitalisierten mittelalterlichen Handschrift - Reklamation eines fehlerhaften Scans

- Die Handschriftensammlung beschließt ein Schutzdigitalisat in hoher Auflösung zu erstellen, um die Originalressource in Zukunft zu schonen. Das ist oft mit hohen Kosten und Aufwand verbunden.

- Ein Scan-Dienstleister wird beauftragt, unter Einhaltung konservatorischer Vorgaben und Metadatenstandards das Digitalisat zu erstellen und legt das vertraglich vereinbarte Digitalisat auf einem Server ab.

- Dort wird es automatisiert abgeholt und in das LZA-System überführt (Ingest).

- Durch die digitale Übermittlung ist die Datei beschädigt.

- Das Dateiformat wird als fehlerhaft erkannt, der Ingest wird vom System abgebrochen.

- Die Handschriftensammlung urgiert beim Dienstleister eine nochmalige Lieferung eines unbeschädigten Digitalisates.

- Die Fehlerbehebung erfolgt durch den Dienstleister.

2) Pflichtablieferung Bundesgesetzblätter

- Die Bundesgesetzblätter im PDF-Format mit Amtssignatur werden über eine Schnittstelle automatisiert abgeholt.

- Die PDF-Dateien passieren die Qualitätskontrolle nicht, da sie in einer nicht spezifizierten PDF-Version geliefert werden.

- Die Bibliothek informiert das zuständige Ministerium, der Ingest wird vorübergehend gestoppt.

- Die Fehlerbehebung erfolgt durch die abliefernde Institution.

Im Webarchiv ist alles anders

Für Daten, die aus der Webarchivierung in ein Langzeitarchivierungssystem kommen, sind die eben erwähnten Abläufe nicht anwendbar, da bereits veröffentlichte Inhalte im Web, nachträglich nicht korrigiert werden können. Jede Änderung an einer Webseite führt zu einer erneuten Veröffentlichung und erzeugt im Webarchiv einen neuen Zeitschnitt. Obwohl es Empfehlungen gibt, wie Webseiten archivierungsfreundlich gestaltet werden sollten9, können Medieninhaber*innen nicht dazu verpflichtet werden, Standards, Richtlinien und bestimmte Formate zu verwenden.

Eine Migration eines einzelnen Dateiformates im archivierten Web hätte weitreichende Auswirkungen auf den Inhalt anderer Objekte, die dann ebenfalls migriert werden müssten. Das grundlegende Prinzip der Hyperlink-Fähigkeit des Webs würde beispielsweise bedeuten, dass bei einer Migration aller „.gif“ zu „.png“ Dateien auch alle HTML-Dateien angepasst werden müssten, die auf solche Dateien verweisen.

Es gibt jedoch Systeme, die für solche Fälle eine sogenannte „Migration on demand“ durchführen können, bei der das LZA-System ein als veraltet gekennzeichnetes Dateiformat beim Abruf in das aktuellste Format umwandelt und der Browser die Daten dieses Formates für die Anzeige der Ausgangsseite nutzt.10

Allerdings scheint angesichts der Vielzahl unterschiedlicher Dateiformate, die in Webarchiven vorhanden sind, eine Migration als keine geeignete Strategie für die Langzeitarchivierung. Im Webarchiv Österreich konnten aktuell aus allen archivierten Objekten 553 unterschiedliche Datei-Signaturen identifiziert werden. Beispielsweise ist das für das Web essentielle HTML-Format derzeit in der PRONOM-Datenbank in sieben verschiedenen Formatversionen und weiteren drei Versionen ohne Angabe einer Versionsnummer vorhanden.

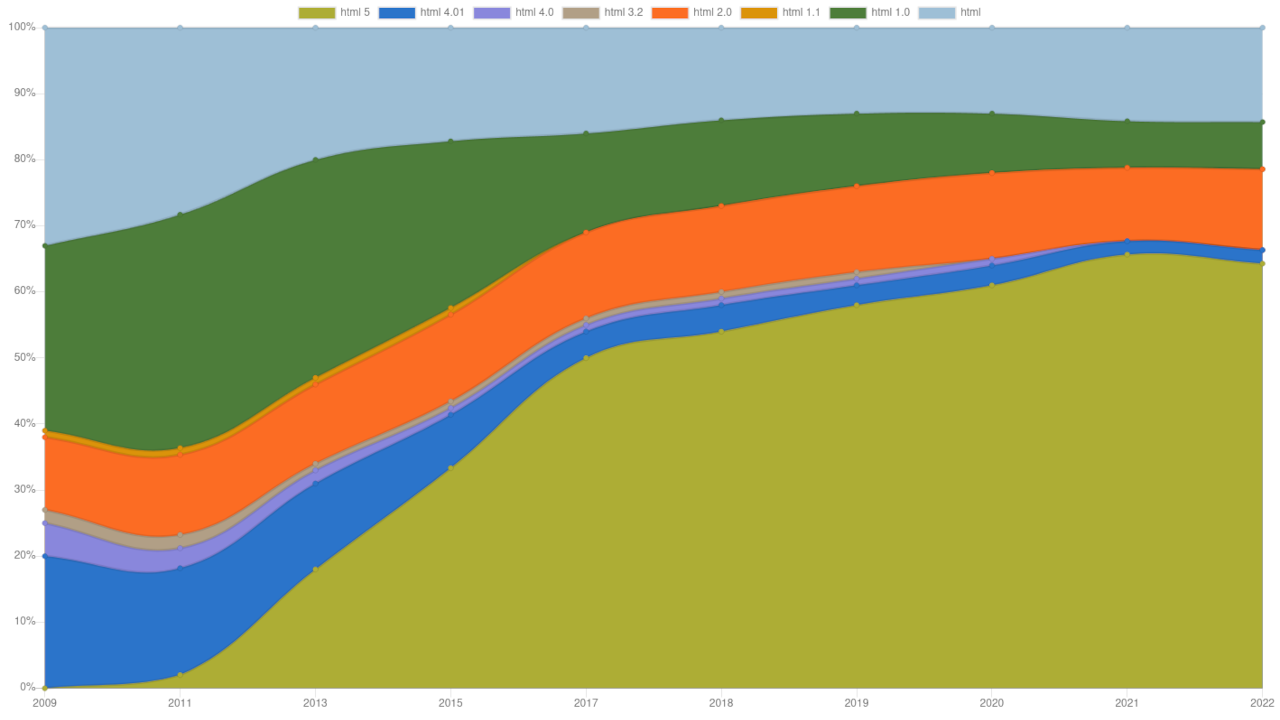

Durch die Analyse sämtlicher identifizierbarer HTML-Seiten aus den vergangenen zehn

Domain-Crawls von 2009 bis 202211 wird deutlich sichtbar, wie erfolgreich sich das aktuelle

HTML 5-Format etabliert hat, während die Versionen 4.0 und 3.2 in den letzten Jahren praktisch kaum noch

anzutreffen sind.

In den letzten Jahren blieb aber der Prozentsatz der HTML-Seiten, die aufgrund

fehlender Merkmale keiner spezifischen Version zugeordnet werden können, auch stabil.

Wenn wir einzelne archivierte Webseiten in den verschiedenen erwähnten Versionen mit einem modernen Browser betrachten, wird offensichtlich, dass moderne Browser schon eine bedeutende Aufgabe der Emulation übernehmen und in der Lage sind, verschiedene, zum Teil veraltete Formate darzustellen.

Fazit

Die Frage, ob Migration oder Emulation die bessere Lösung für die Langzeitarchivierung darstellen, bleibt nach wie vor offen. Derzeit ist es sinnvoll, die Strategie je nach Anwendungsfall zu wählen. Aufgrund der Tatsache, dass das Emulieren von Software, Betriebssystemen und Hardware wesentlich einfacher geworden ist und viele dieser Funktionen heutzutage problemlos vom Browser ausgeführt werden können, wird der Browser in Zukunft eine immer wichtigere Rolle in der Langzeitarchivierung spielen.

Die Österreichische Nationalbibliothek bedankt sich sehr herzlich beim Wiener Städtische Versicherungsverein für die Unterstützung des Webarchivs Österreich.

Über die Autor*innen: Karin Heide ist Projektverantwortliche für digitale Langzeitarchivierung an der Österreichischen Nationalbibliothek, Andreas Predikaka ist technisch Verantwortlicher des Webarchivs Österreich an der Österreichischen Nationalbibliothek.

Fußnoten:

1 Liegmann, Hans, Nestor Handbuch: Eine kleine Enzyklopädie der digitalen Langzeitarchivierung, Einführung, [online] » urn:nbn:de:0008-2010071949 [31.05.2023]

3 Eines der ersten bedeutenden Projekte auf dem Gebiet der digitalen Langzeitarchivierung war das "Electronic Recording Machine, Accounting" (ERMA)-System, das in den 1950er Jahren von der Bank of America entwickelt wurde. Dabei handelte es sich um ein computergestütztes System zur Verarbeitung von Scheckzahlungen.

4 Beispielhaft erwähnt sei hier das Projekt „Digital Sky Survey“ (DSS), das in den 1980er Jahren startete und zum Ziel hatte, die gesamte Himmelsdurchmusterung in digitaler Form zu erfassen und zu archivieren. Dabei wurden alte fotografische Platten und Dias astronomischer Aufnahmen gescannt und digitalisiert. Die DSS bildete die Grundlage für spätere digitale Himmelskarten und ermöglichte die systematische Archivierung und den einfachen Zugriff auf astronomische Beobachtungsdaten. Die erste Version des DSS wurde 1994 auf 102 CDs veröffentlicht. [online] » https://en.wikipedia.org/wiki/Digitized_Sky_Survey [31.05.2023]

5 "Das als ISO 14721:12 verabschiedete Referenzmodell `Open Archival Information System – OAIS` beschreibt ein digitales Langzeitarchiv als eine Organisation, in dem Menschen und Systeme mit der Aufgabenstellung zusammenwirken, digitale Informationen dauerhaft über einen langen Zeitraum zu erhalten und einer definierten Nutzerschaft verfügbar zu machen.“ Brübach, Nils, Das Referenz Modell OAIS in: Nestor Handbuch: Eine kleine Enzyklopädie der digitalen Langzeitarchivierung, [online] urn:nbn:de:0008-2010061762 [31.05.2023]. Siehe auch: [online] » http://www.oais.info [31.05.2023]

6 Vlaeminck, Sven, Nestor Handbuch: Eine kleine Enzyklopädie der digitalen Langzeitarchivierung, Organisation, [online] » urn:nbn:de:0008-20100624144 [31.05.2023]

7 Die Zertifizierung als vertrauenswürdiges Langzeitarchiv setzt die Implementierung des OAIS-Referenzmodells voraus. Mittlerweile haben sich drei Verfahren etabliert, die die Umsetzung des funktionalen OAIS-Modells überprüfen: CoreTrustSeal (CTS) [online] » https://www.coretrustseal.org [31.05.2023], nestor Siegel/DIN 31644 [online] https://www.langzeitarchivierung.de/Webs/nestor/DE/Arbeitsgruppen/AG_Zertifizierung/ag_zertifizierung.html [31.05.2023], ISO 31644 [online] » http://www.iso16363.org [31.05.2023]

8 Neubauer, Mathias, Extraktion, technische Metadaten und Tools in: Nestor Handbuch: Eine kleine Enzyklopädie der digitalen Langzeitarchivierung, [online] » urn:nbn:de:0008-20100617150 [31.05.2023]

9 [online] » https://www.nationalarchives.gov.uk/aboutapps/pronom/default.htm [31.05.2023]

10 Empfehlung der Library of Congress zur Erstellung archivierungsfreundlicher Webseiten: [online] » https://web.archive.org/web/20221020184535/» https://www.loc.gov/programs/web-archiving/for-site-owners/creating-preservable-websites/ [31.05.2023]

11 Vgl. Brown, Adrian (2006): Archiving websites : a practical guide for information management professionals, London: Facet Publ., 97f

12 Für die Analyse wurden von jedem Domain-Crawl sämtliche erfolgreich identifizierten HTML-Dateien der ersten Stufe (Crawl jeder Domain bis zu einer Größe von 10 MB) herangezogen. Vgl. : Predikaka, Andreas (2020): "Wie das österreichische Web im Archiv landet", [online] » https://www.onb.ac.at/mehr/blogs/detail/wie-das-oesterreichische-web-im-archiv-landet-3 [26.07.2023]

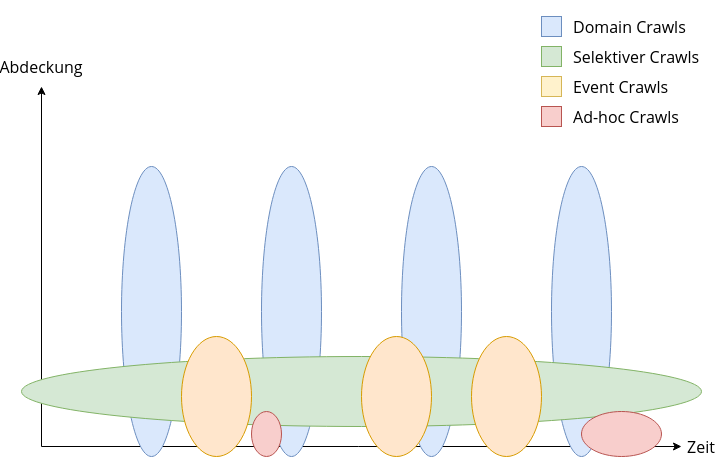

Wie wird eine nationale Domain-Landschaft gecrawlt?

Autor: Andreas Predikaka

Seit 1. März 2009 ist die Österreichische Nationalbibliothek gesetzlich ermächtigt das nationale Web zu

sammeln. Während Webkurator*innen für bestimmte Themenbereiche wie Medien, Politik, usw. laufend

relevante, sammlungswürdige Webseiten auswählen und diese in geeigneten Speicherintervallen im Rahmen

von Selektiven Crawls für die nachfolgenden Generationen archivieren lassen, werden zusätzlich

regelmäßig alle bekannten Domains des österreichischen Webs automatisiert gespeichert. Diese Art der

Archivierung wird „Domain Crawl“ genannt und dient dazu ein einmaliges, oberflächliches Abbild des

gesamten nationalen Webs zu schaffen. Paragraph 43b des Mediengesetzes definiert den österreichischen

Webspace wie folgt:

"§ 43b. (1) Die Österreichische Nationalbibliothek ist höchstens

viermal jährlich zur generellen automatisierten Sammlung von Medieninhalten periodischer elektronischer

Medien [...] berechtigt, die öffentlich zugänglich und 1. unter einer ".at"-Domain abrufbar

sind oder 2. einen inhaltlichen Bezug zu Österreich aufweisen."1

Vor allem

Punkt zwei bedeutet in der Praxis einen laufenden kuratorischen Aufwand, um Domains mit Österreich-Bezug

ausfindig zu machen.2 Aus diesem Grund ist es notwendig die Ausgangsadressen für jeden neuen

Domain Crawl an aktuelle Gegebenheiten und Entwicklungen anzupassen, um dadurch mehr nationale Inhalte

crawlen und den potentiellen Verlust wichtiger Inhalte verringern zu können.

Domainnamen-Listen

Viele relevante Domainnamen für diese Art des Crawls melden uns Webkurator*innen und Leser*innen3 oder sind Ergebnis von halbautomatischen Suchverfahren. Aber der Großteil der Namen wird über Listen unterschiedlicher Domain-Registrierungsstellen bezogen.

Ursprünglich wurden die ersten .at Domain-Registrierungen noch von der Universität Wien verwaltet, aber die hohe Nachfrage an Domainnamen machte es notwendig die Domainverwaltung als Dienstleistungsunternehmen zu etablieren, was im Jahr 2000 in Form der nic.at geschah, die seither die .at Domain administriert.4 Die Verwaltung des Namensraumes für akademische Einrichtungen .ac.at verblieb bei der Universität Wien. Neben der Namen der .at Domain, ist nic.at auch noch für die Verwaltung der für kommerziell orientierte Unternehmen vorgesehenen Subdomain .co.at, und für den Namensbereich .or.at zuständig. Die wenig bekannte Subdomain .priv.at wurde 1995 geschaffen, um eine kostengünstige Domain-Zone für Privatpersonen in Österreich zu schaffen. Die Verwaltung dieser Subdomain obliegt zur Zeit dem Verein VIBE!AT.5 Der weithin bekannte Namensraum .gv.at ist für Bundes- und Landesbehörden vorgesehen und wird dementsprechend vom Bundeskanzleramt verwaltet.

In Folge der Einführung der neuen generischen Domains6 im Jahre 2013 wurden die Namen der beiden Top Level Domains .wien und .tirol aufgrund des eindeutigen inhaltlichen Bezuges zu Österreich vollständig für den Domain Crawl übernommen. Für deren Verwaltung sind die punkt.wien GmbH7 bzw. punkt Tirol GmbH8 verantwortlich. Alle Namen dieser beiden Top-Level-Domains werden direkt von der Internet Corporation for Assigned Names and Numbers (ICANN)9 bezogen.

All diese gesammelten Domainnamen dienen als Datenbasis für den jährlich durchzuführenden Domain Crawl. Während der erste Crawl 2009 knapp 900.000 Domains umfasste, fanden 2022 bereits knapp 1,5 Millionen Domainnamen Verwendung.

Webseiten werden mit einem Crawler im Webarchiv gespeichert. Dabei startet ein Crawler bei einer Ausgangsadresse, folgt jedem Verweis auf der Seite und speichert alle Inhalte bis ein definiertes Limit erreicht ist.10

Ein Domainname ist jedoch keine Webadresse. Es fehlt noch der Name des Webservers, auf dem die Webseite gehostet wird. Da diese Information für die gesammelten Domainnamen nicht bekannt ist, wird der übliche Hostname www in Verbindung mit dem Kürzel des Protokolls http jedem Domainnamen vorangestellt, um so eine für den Crawler gültige Ausgangsadresse zu erzeugen. Aus dem Domainnamen onb.ac.at wird beispielsweise die Adresse http://www.onb.ac.at. In den meisten Fällen kann so die Startseite des wichtigsten Webserver der Domain erreicht werden. Sind für eine Domain weitere Hostnamen bekannt, werden diese in einem manuellen Prozess als weitere Ausgangsadressen erfasst (z.B. http://webarchiv.onb.ac.at , http://labs.onb.ac.at usw.).

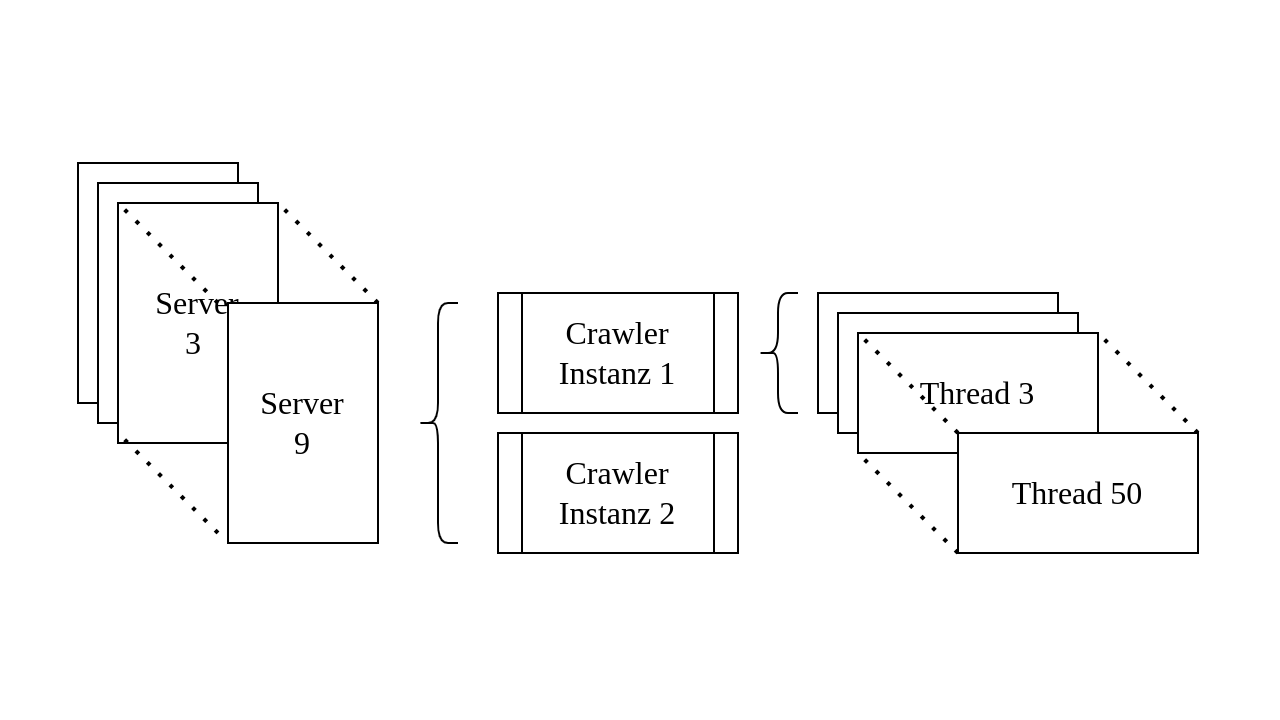

Crawl-Management

Das Archivieren von mehr als einer Million Startadressen kann nicht mit einem Crawler auf einmal durchgeführt werden. Die Ausgangsadressen müssen portionsweise an eine Vielzahl von Crawler-Instanzen übergeben werden. Die Aufteilung aller Adressen auf viele Instanzen übernimmt das Software-System NetarchiveSuite, das im Rahmen des dänischen Webarchivierungsprojektes von der Dänischen Königlichen Bibliothek entwickelt und 2007 als Open Source Software zur Verfügung gestellt wurde. Inzwischen wird das System von einem Zusammenschluss von der KB Dänemark, der Französischen, Spanischen, Schwedischen und Österreichischen Nationalbibliothek weiterentwickelt.11 In der aktuellen Infrastruktur der Österreichischen Nationalbibliothek stehen für den Domain Crawl neun Server mit je zwei Crawler-Instanzen zu je 50 Threads zur Verfügung. Auf diese Weise können theoretisch Objekte von bis zu 900 Domains gleichzeitig angefordert und gespeichert werden. Jeder Crawler wird mit maximal 2500 Ausgangsadressen gestartet.

Die Anzahl der eingesetzten Server und Instanzen muss natürlich immer im Einklang der zugesicherten Bandbreite des Internets stehen, ansonsten könnten Serveranfragen nicht mehr schnell genug abgeholt werden, was zu unvollständigen Datenübertragungen und dadurch zu korrupten Downloaddaten führen könnte. Alle Crawler-Instanzen laufen für alle Domains mit denselben Einstellungen und speichern alle Objekte, die nach der Ausgangsadresse auf der Ausgangsdomain zu erreichen sind. Um zu verhindern, dass bei Erreichen des Gesamtspeicherlimits große Domains komplett und viele kleine Domains noch gar nicht gecrawlt wurden, wird ein Domain Crawl stufenweise durchgeführt. Alle Domains werden am Beginn bis zu einer Gesamtspeichermenge von zehn MB gecrawlt, was für 95 Prozent aller Domains bereits reicht, um sie vollständig zu archivieren. Mit dem aktuellen Speicherbudget ist es möglich alle noch nicht vollständig gecrawlten Domains, noch einmal bis zu einer neuen Grenze von 100 MB zu crawlen. Bei genügend verfügbaren Speicher könnte man mit dieser Vorgangsweise einen vollständigen Crawl der gesamten nationalen Domainlandschaft durchführen, was aus Kapazitätsgründen bisher noch nie stattfinden hat können.

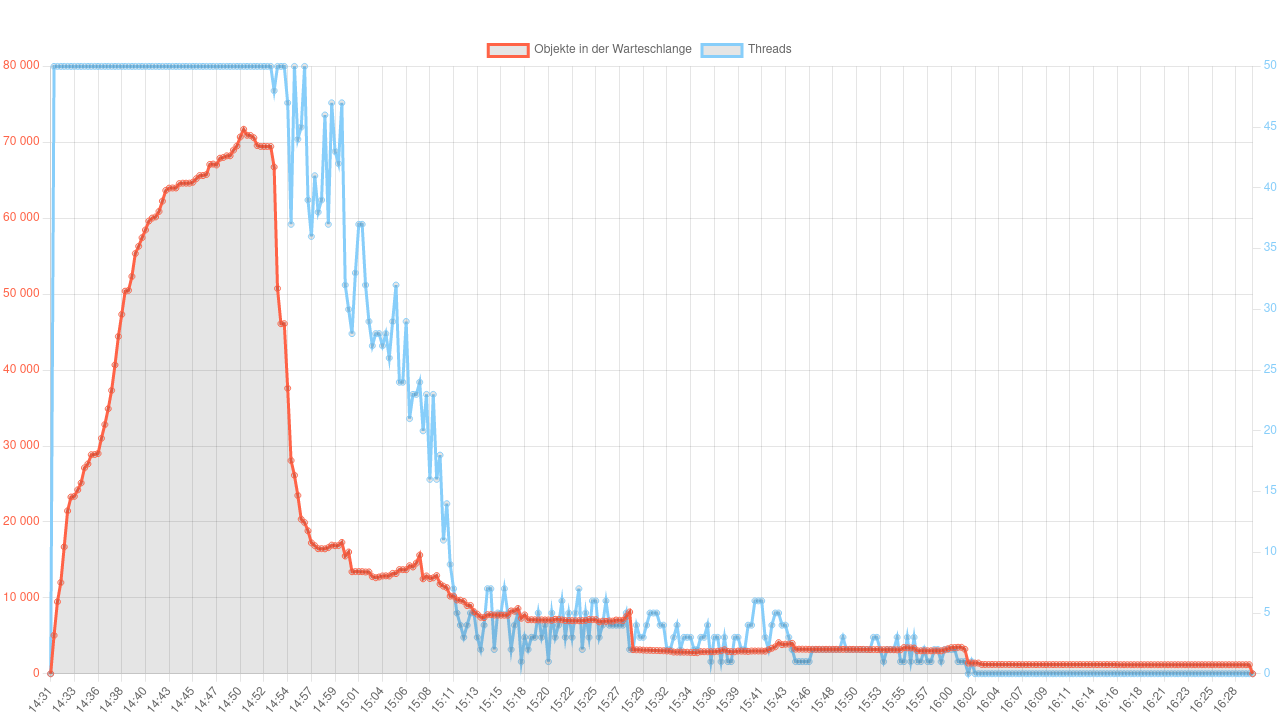

Die Crawler sind so konfiguriert, dass sie sich wie im Web surfende Menschen verhalten. Nach dem Laden aller referenzierten Objekte einer Seite bzw. nach dem Erreichen einer definierten Gesamtspeichermenge macht der Crawler eine kurze Pause um einerseits den Zielserver zu entlasten und andererseits den verwendeten Crawler-Thread für Anfragen an die nächste wartende Domain freizugeben. Auch auf die Antwortzeiten der Server wird Rücksicht genommen. Benötigt ein Server für eine Antwort länger, wird der Zeitabstand bis zur nächsten Anfrage größer. Am Beginn eines sogenannten Crawl-Jobs ist eine Instanz mit der gesamten verfügbaren Thread-Anzahl ausgelastet. Die Crawl-Dauer eines Jobs wird einerseits durch die Anzahl der Threads pro Crawler-Instanz und andererseits durch die Menge der Ausgangsadressen und der maximalen Speichergrenze pro Domain bestimmt. Da alle Server unterschiedliche Antwortzeiten haben, werden nicht alle Domains eines Jobs gleich schnell gecrawlt. Das hat zur Folge, dass ein Job immer dieselbe Verlaufskurve beschreibt.

Alle Threads werden eine bestimmte Zeit vollständig benutzt und nach einer gewissen Zeit sind immer weniger in Verwendung. Am Ende wird nur mehr ein Thread für wenige noch nicht fertig gecrawlte Domains benötigt. Sobald die letzte Domain aus dem Job die Abbruchbedingung erreicht hat, ist der Crawl-Job beendet und eine weitere Crawler-Instanz mit neuen Ausgangsadressen wird automatisch gestartet. Bleibt ein Crawl-Job im Vergleich zu anderen Jobs auffällig lange aktiv und wird nicht beendet, so ist der Crawler höchstwahrscheinlich in einer sogenannten Crawler-Trap gefangen, aus der er befreit werden muss.

Crawler-Traps

Auch wenn ein Domain Crawl mit so wenig Interaktion wie möglich laufen sollte, kommt irgendwann der Zeitpunkt, an dem es notwendig ist manuell einzugreifen. Oft gelangt ein Crawler auf Webseiten in einen Kalender, bei dem über Verweise Tage, Wochen, Monate oder Jahre verändert werden können. Jedes neue Kalenderblatt generiert eine neue Seite mit neuen Links. Der Crawler bleibt in diesem Kalender "gefangen" und kann sich erst selbst befreien, wenn vordefinierte Abbruchbedingungen erreicht werden, was sehr lange dauern kann. Daher sollte zu diesem Zeitpunkt der Crawl-Engineer manuell eingreifen und die betroffenen Links aus der Crawl-Warteschlange entfernen. Die gespeicherten Daten aus dem Kalender wären zwar valide, aber die meisten wahrscheinlich nicht sehr relevant.

Es gibt aber auch Werkzeuge, sogenannte "Honey-Pots" 12, die von Webadministratoren eingesetzt werden, um bösartige, datensammelnde Crawler ins Leere oder Endlose laufen zu lassen. Das passiert häufig bei Missachtung von Ausschlussregeln, die auf jedem Webserver in der sogenannten robots.txt13 oder in Meta-Tags14 auf HTML-Seiten definiert werden können. Diese Regeln dienen den Betreibern von Webseiten dazu, gewisse Bereiche ihrer Seite für Crawler zu sperren bzw. nur bestimmte Crawler zuzulassen. Diese Anweisungen sind allgemein anerkannt und Crawler sollten sich daranhalten, jedoch kann ein Zugriff auf damit "gesperrte" Inhalte ohne weitere Absicherungsmaßnahmen nicht verhindert werden.

Da die Webarchivierung im gesetzlichen Auftrag betrieben wird und gegenüber diesen Anweisungen Vorrang hat, können solche Fallen für Crawler der Österreichische Nationalbibliothek zum Problem werden. Gelangt ein Crawler in einen Bereich, den er eigentlich nicht betreten sollte, könnte dort ein Honey-Pot warten, der ihn so lange ins Unendliche laufen lassen würde, bis er erst durch eine Abbruchbedingung oder durch manuelle Intervention befreit würde. Leider mit dem bitteren Beigeschmack, dass dabei Daten von zufällig sinnfrei aneinandergereihten Wörtern ins Webarchiv gelangen könnten.

Für diese Fälle sind sehr knappe Speicherbudgets sogar ein Segen, weil in unentdeckten Fällen, nicht zu viel Speicherplatz verloren geht (aktuell pro Domain und Durchlauf max. zehn bzw. 100 MB).

Mit aktuellem Stand sind bisher 55 Prozent (über 120 TB) aller gesammelten Daten des österreichischen Webs über Domain Crawls ins Archiv gelangt. Auch wenn der Vorgang eines Domain Crawls nach sorgfältiger Vorbereitung automatisch ablaufen kann, ist man gut beraten, wenn man dennoch ein Auge auf ihn behält.

Die Österreichische Nationalbibliothek bedankt sich sehr herzlich beim Wiener Städtische Versicherungsverein für die Unterstützung des Webarchivs Österreich.

Über den Autor: Mag. Andreas Predikaka ist technisch Verantwortlicher des Webarchivs Österreich an der Österreichischen Nationalbibliothek.

Fußnoten:

1 Änderung des Mediengesetzes: BGBl. I

Nr. 8/2009, § 43: »

https://web.archive.org/web/20151028093639/https://www.ris.bka.gv.at/Dokumente/BgblAuth/BGBLA_2009_I_8/BGBLA_2009_I_8.html[25.11.2022]

2

Vgl. die Kriterien zur Einstufung von sogenannten Austriaca: Mayr, Michaela / Andreas Predikaka (2016):

Nationale Grenzen im World Wide Web - Erfahrungen bei der Webarchivierung in der Österreichischen

Nationalbibliothek. In: BIBLIOTHEK Forschung und Praxis 40/1, 91, [online] doi.org/10.1515/bfp-2016-0007

[25.11.2022]

3 Über Webformular oder Bookmarklet auf [online] »

https://webarchiv.onb.ac.at/#nominierung [25.11.2022]

4 [online] »

https://web.archive.org/web/20221017080623/https://www.nic.at/de/das-unternehmen/firmengeschichte

[25.11.2022]

5 [online] »

https://web.archive.org/web/20221017102027/http://www.vibe.at [25.11.2022]

6 [online]

»

https://de.wikipedia.org/wiki/Neue_Top-Level-Domains [25.11.2022]

7 [online] »

https://web.archive.org/web/20221120160048/https://www.nic.wien/de/wien/projekt-wien

[25.11.2022]

8 [online] »

https://web.archive.org/web/20221120160154/http://www.nic.tirol/ueber-uns/ueber-punkt-tirol/

[25.11.2022]

9 [online] »

https://de.wikipedia.org/wiki/Internet_Corporation_for_Assigned_Names_and_Numbers

[25.11.2022]

10 Vgl.: Predikaka, Andreas (2020): "Wie das archivierte

österreichische Web im Archiv landet", [online] »

https://www.onb.ac.at/mehr/blogs/detail/wie-das-oesterreichische-web-im-archiv-landet-3

[26.07.2023]

11[online] »

https://github.com/netarchivesuite/netarchivesuite [25.11.2022]

12 z.B.: [online]

» https://www.projecthoneypot.org

[25.11.2022]

13 [online] »

https://de.wikipedia.org/wiki/Robots_Exclusion_Standard [25.11.2022]

14 [online]

»

https://de.wikipedia.org/wiki/Meta-Element#Anweisungen_f%C3%BCr_Webcrawler [25.11.2022]

Datendeduplizierung. Wie das Webarchiv beim täglichen Crawlen von Webseiten Speicherplatz spart

Autor: Andreas Predikaka

Durch das schnelle und stetige Anwachsen des österreichischen Webs benötigt das Webarchiv Österreich laufend weiteren Speicherplatz, um ein signifikantes Abbild des heimischen Webspaces für die Nachwelt bewahren zu können. Dabei gilt es, sorgsam mit dem bereitgestellten Speicher umzugehen und diesen optimal zu nutzen. Dafür sind zwei Vorgänge für das Webarchiv mittlerweile gängige Praxis und unverzichtbar geworden: Datenkomprimierung und Datendeduplizierung.

Datenkomprimierung

Wie in vielen anderen Bereichen kommt auch in der Webarchivierung Datenkompression zum Einsatz. Im Webarchiv Österreich wird jedes gecrawlte Web-Objekt vor dem Speichern verlustfrei mit dem quelloffenen gzip 1 Programm komprimiert und in einer Archiv-Datei gespeichert. Das Programm verwendet den gemeinfreien Deflate-Algorithmus 2 zur verlustfreien Datenkompression.

Abhängig vom jeweiligen Dateityp können dabei unterschiedliche Kompressionsraten erzielt werden.

Textdateien, wie die im Web üblichen HTML-Dateien, können mit einer sehr hohen Rate komprimiert werden.

Bei Bilddateien ist das hingegen oft nicht der Fall, da diese für die Verwendung im Web meist schon

komprimiert wurden.

Im Webarchiv Österreich wird zurzeit für alle gecrawlten Web-Objekte

(aktuell 138 Terabytes) eine Komprimierungsrate von 1,7 erreicht, was eine Speicherplatzersparnis von 42

Prozent bedeutet. Der auf den Festplatten benötigte Speicher beträgt dadurch nur mehr knapp 80 Terabytes.

Für alle erzeugten Metadaten (aktuell 19,5 Terabytes), die aus gut komprimierbaren Textdateien bestehen, kann sogar eine Komprimierungsrate von knapp 11 erreicht werden, womit eine Speicherplatzersparnis von knapp 91 Prozent erzielt wird. Nur mehr knapp zwei Terabytes an Metadaten werden dafür im Speichersystem benötigt.

Datendeduplizierung

Ausgewählte Seiten aus dem Bereich Medien und Politik werden im Webarchiv Österreich seit über zehn Jahren in eigenen Kollektionen gespeichert. Da bei diesen Seiten eine hohe Änderungsfrequenz zu erwarten ist, werden diese, immer unter Berücksichtigung des aktuellen Speicherbudgets, mindestens einmal pro Tag gecrawlt. Dabei werden unvermeidbar immer wieder die gleichen Daten, wie z.B. Parteilogos oder Bilder von Personen gespeichert, was zu einer Vielzahl an Redundanzen führt und das vorhandene Speicherbudget schneller verbrauchen lässt.

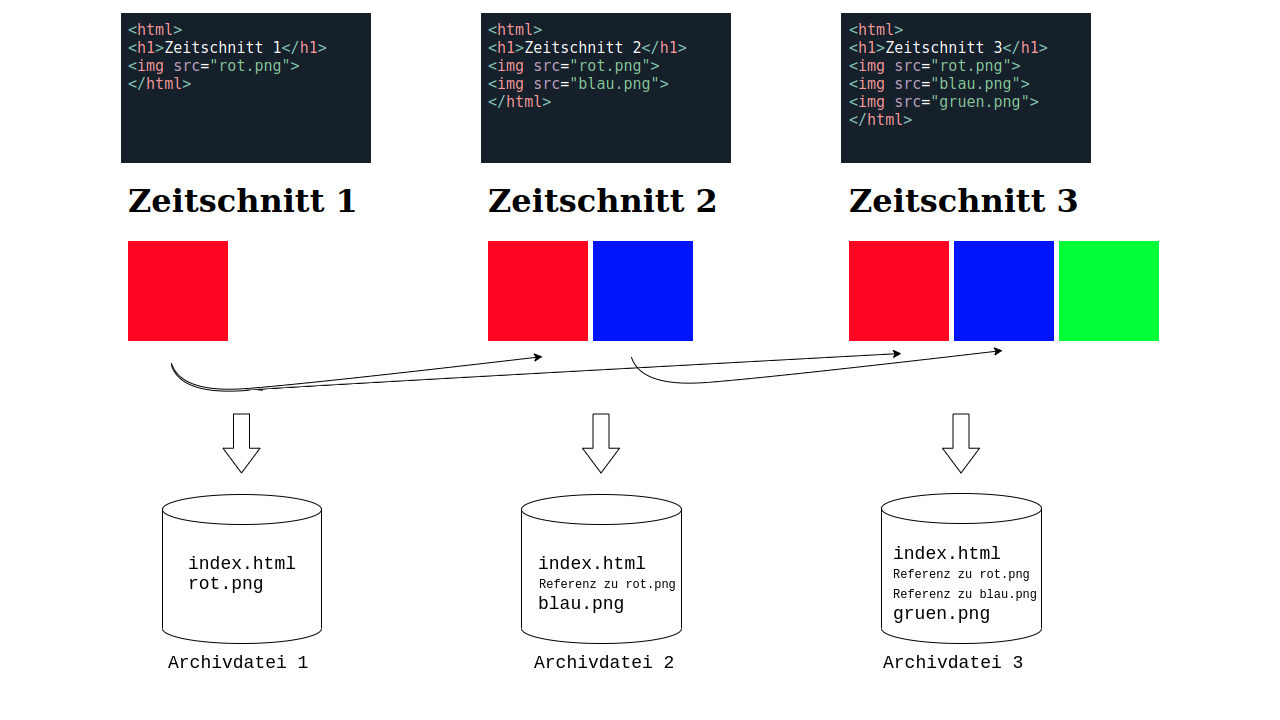

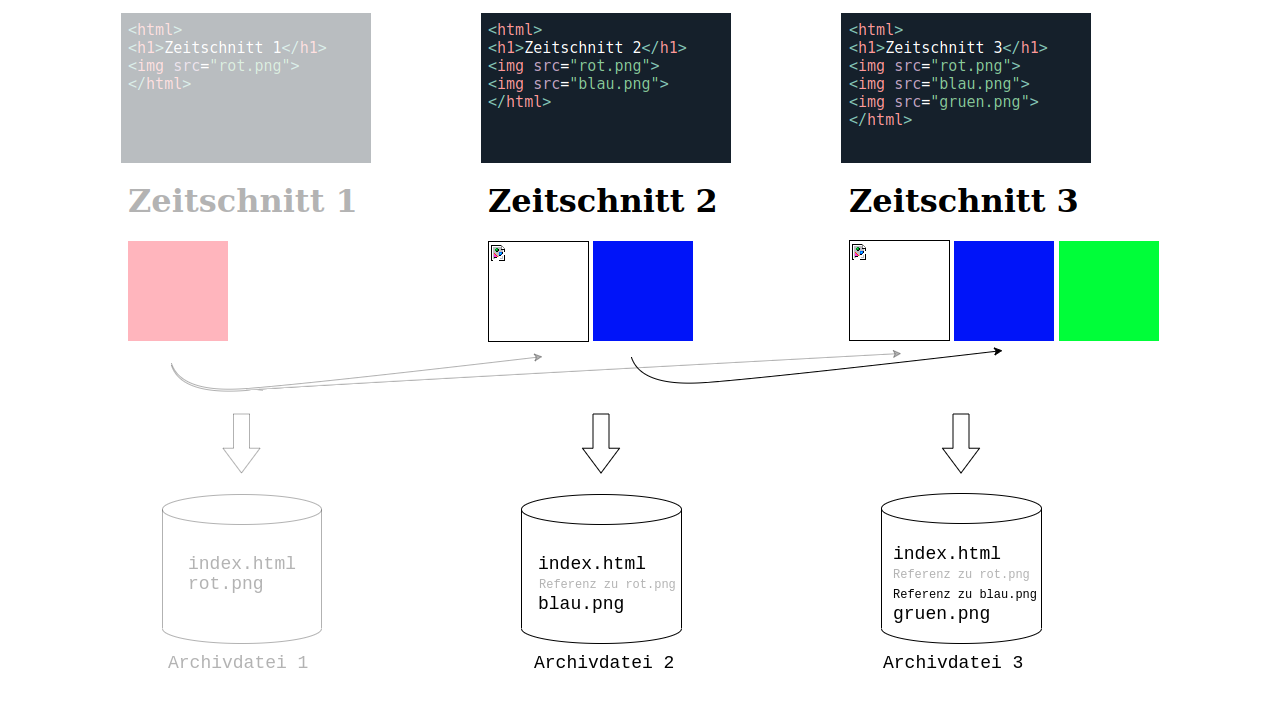

Um diese Redundanzen teilweise einzuschränken, verwendet das Webarchiv die Methode der Deduplizierung. Sie ermöglicht es, einen großen Teil der binären Objekte (Bilder, Videos, Dokumente, Skripte, usw.) dieser regelmäßig gecrawlten Seiten nur als Referenz zum Erstauftreten des jeweiligen Objektes zu speichern. Wie funktioniert das?

Für jedes Objekt, das im Webarchiv gespeichert werden soll, wird ein Hashwert 3 erzeugt, der das Objekt eindeutig identifiziert. Beim erstmaligen Auftreten eines Objektes wird dieses archiviert und der dafür errechnete Hashwert bekommt die exakte Position des Objektes im Webarchiv hinterlegt. Dadurch kann beim wiederholten Crawlen eines bereits existierenden Objektes diese Position anstelle der Daten des Objektes gespeichert werden.

Ist ein auf diese Weise dedupliziertes Objekt Bestandteil einer archivierten Webseite, wird beim Aufruf dieser Seite in der Waybackmachine das Objekt von der referenzierten Position im Webarchiv geladen und angezeigt. 4

HTML-Dateien werden von der Deduplizierung ausgenommen, weil bei diesen Dateien in regelmäßigen Crawls die häufigsten Änderungen zu erwarten sind, wodurch sie nicht mehr für eine Deduplizierung in Frage kämen. Für unveränderte HTML-Dateien wäre eine Speicherplatzersparnis minimal, weil ihre Textinhalte bereits sehr gut komprimiert werden können.

Deduplizierung ist aber auch zu einem gewissen Grad risikobehaftet. Sollte es im Webarchiv zu Datenverlusten kommen und wären Objekte, die referenziert wurden, davon betroffen, könnten die Rückverweise nicht mehr aufgelöst werden und der Datenverlust würde sich um die Anzahl der Referenzen multiplizieren. Deshalb wird bei regelmäßigen Crawls auch immer wieder ein sogenannter "Clean Crawl" durchgeführt, der auf Deduplizierung verzichtet und dadurch wieder neue Ausgangsobjekte für neue Referenzen weiterer Deduplikationen bildet. Auf diese Weise streuen sich die Originalobjekte im Webarchiv, was den Schaden bei eventuellen Datenverlusten reduzieren kann.

Zu den am häufigsten deduplizierten Objekten im Webarchiv Österreich zählt eine 1x1 Pixel große transparente GIF-Datei mit 43 Bytes, die vor allem auf älteren archivierten Webseiten verwendet wurde, um das Layout dieser Seiten zu beeinflussen. Über 2,3 Millionen Mal wurde dieses Objekt auf unterschiedlichen Webseiten dedupliziert. Für diese kleine Datei ist der Speicherplatzgewinn aufgrund der nur unwesentlich kleineren Information über die Referenz aber sehr gering.

Ganz anders beim Objekt mit der meisten Speicherplatzersparnis, einem Video über eine Pressekonferenz 5, das zwar nur 1225-mal dedupliziert wurde, aber dadurch knapp 170 Gigabytes an Speicher einsparen konnte.

Gesamt wurden im Webarchiv Österreich bis jetzt 882 Millionen Objekte mit einer Gesamtgröße von über 59 Terabytes dedupliziert, was 30 Prozent der unkomprimierten Speichergröße des Archivs ausmacht.

Die Österreichische Nationalbibliothek bedankt sich sehr herzlich beim Wiener Städtische Versicherungsverein für die Unterstützung des Webarchivs Österreich.

Über den Autor: Mag. Andreas Predikaka ist technisch Verantwortlicher des Webarchivs Österreich an der Österreichischen Nationalbibliothek.

Quellen:

1 [online] https://de.wikipedia.org/wiki/Gzip

, [22.06.2022]

2 [online] https://de.wikipedia.org/wiki/Deflate

, [22.06.2022]

3 [online] https://de.wikipedia.org/wiki/Hashfunktion

, [22.06.2022]

4 Vgl.: Predikaka, Andreas (2020): "Wie das archivierte österreichische Web wieder

auf den Bildschirm kommt", [online] https://www.onb.ac.at/mehr/blogs/detail/wie-das-archivierte-oesterreichische-web-wieder-auf-den-bildschirm-kommt-3

, [26.07.2023]

5 Alle Zeitschnitte dieses Videos können im Webarchiv Österreich angezeigt werden: https://webarchiv.onb.ac.at/?q=http://www.wien-konkret.at/fileadmin/content/Politik/Wahlrecht/video-pk-faires-wahlrecht.flv

Wie Sie Webseiten im archivierten Web suchen, finden und sich anzeigen lassen können

Autor: Andreas Predikaka

Von der vorwissenschaftlichen Arbeit über die Bachelorthesis bis hin zur Dissertation haben Zitierregeln für Quellen aus dem Web eines gemein: Neben dem Titel ist zusätzlich zur Webadresse auch das Zugriffsdatum anzugeben. Die Schreibenden stellen damit klar, welcher Zeitschnitt einer bestimmten Webadresse für ihre Arbeit relevant war. Nur selten gibt es aber einen Hinweis darauf, wie das jeweilige Web-Zitat am besten zu rekonstruieren ist.1 Die Autor*innen verlassen sich meist darauf, dass das Web nichts vergisst. Aber das Web vergisst leider viel von den Inhalten, die im Nachhinein als relevant erachtet werden.

Die Leser*innen sind meist darauf angewiesen, dass eine Webadresse zum oder rund um das Zugriffsdatum der Schreibenden von Webarchiven gespeichert wurde und sich der archivierte vom referenzierten Inhalt nicht (maßgeblich) unterscheidet.

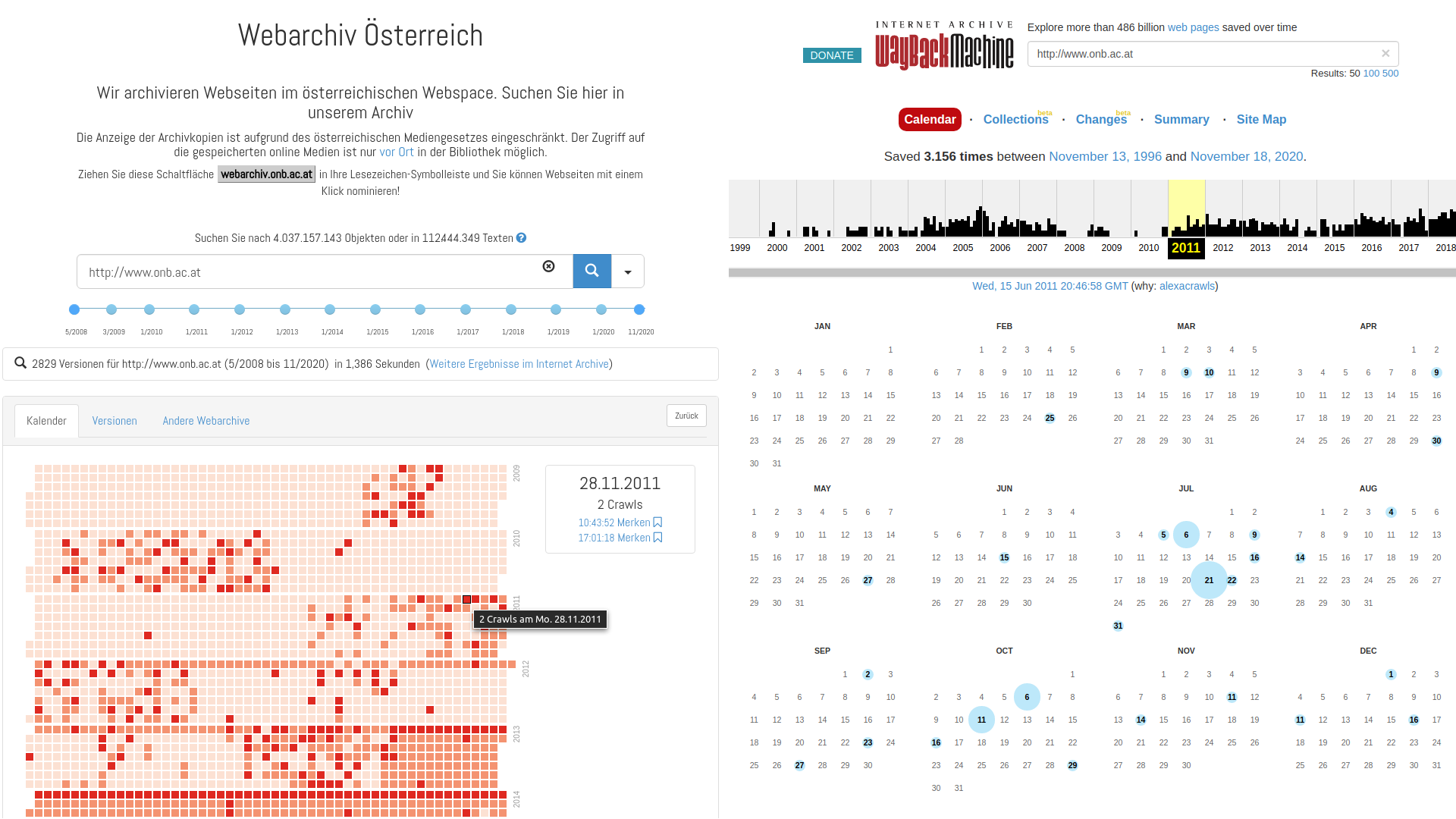

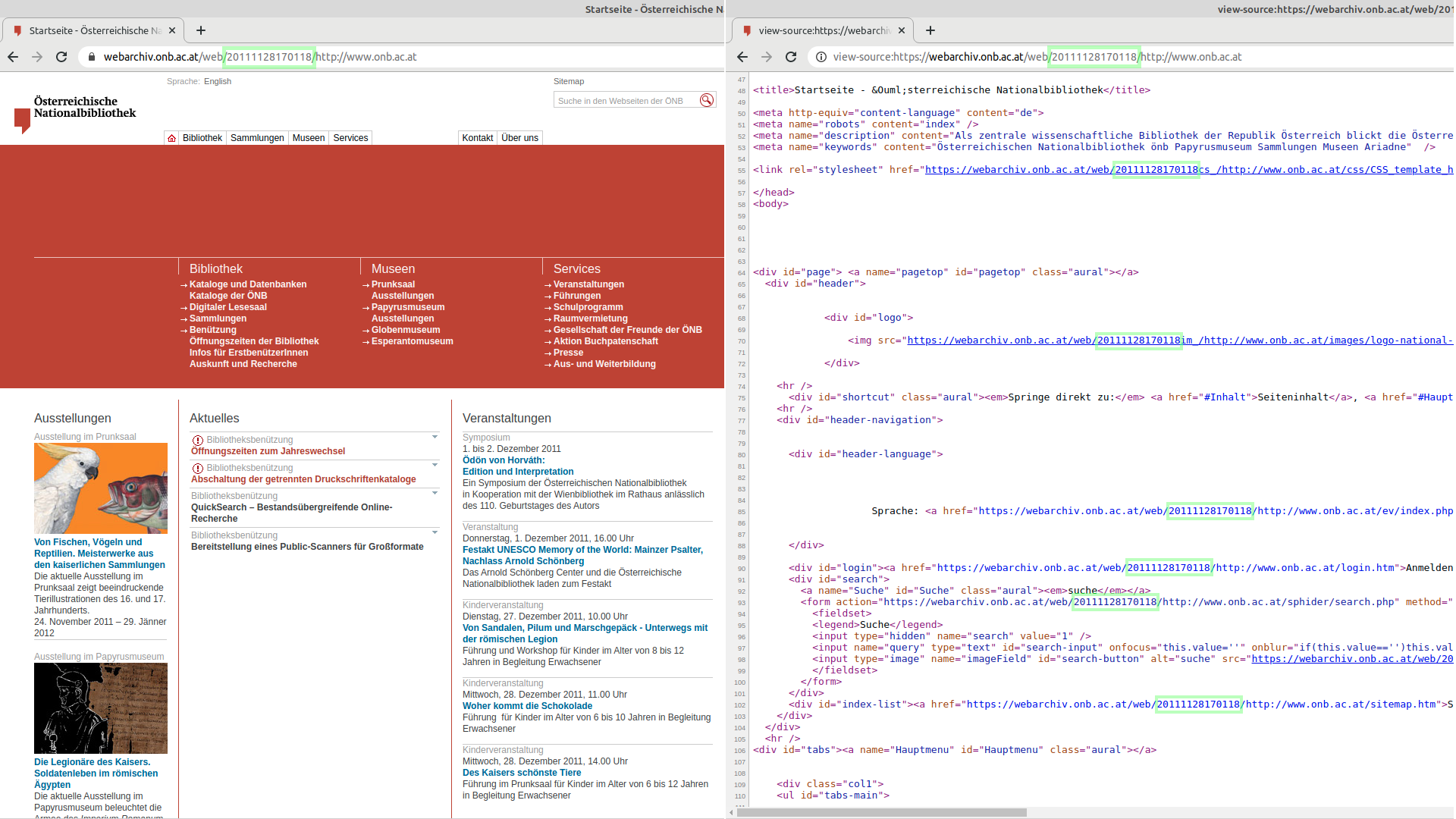

Um ein Web-Zitat zu finden und um festzustellen, ob ein Zeitschnitt einer Adresse im archivierten Web vorhanden ist, gilt das Internet Archive2 als erste Anlaufstelle für die Suche und Anzeige von archivierten Webseiten. Seit 1996 versucht die gemeinnützige Organisation aus den Vereinigten Staaten das gesamte Web zu archivieren und seit 2001 bietet sie auch den Zugriff auf die archivierten Daten über die sogenannte „Wayback-Machine“ an.3 Kann man über die Eingabe einer Webadresse ein passendes Ergebnis finden und lässt sich diese archivierte Website auch noch wiederherstellen, so wird sie am Bildschirm angezeigt. Dass Inhalte aus Webarchiven öffentlich zugänglich sind, ist aber nicht selbstverständlich. Grundsätzlich unterliegen diese dem Urheberrecht und dürfen ohne Zustimmung der Medieninhaber*innen nicht angezeigt werden. Das Internet Archive nimmt für sich das sogenannte "Fair Use Prinzip”4 in Anspruch, das in den Vereinigten Staaten eine Nutzung von geschütztem Material zu Bildungszwecken erlaubt. Gleichzeitig gibt es für den Dienst eine Opt-Out-Möglichkeit. Wünschen Medieninhaber*innen die Entfernung ihrer Einträge aus dem Archiv, so wird dem Anliegen in der Regel nachgekommen. Es kann also durchaus passieren, dass archivierte, erfolgreich rekonstruierte Webinhalte, beim nächsten Aufruf nicht mehr verfügbar sind. Ein Dilemma.

Ab Ende der 1990er Jahre wurde die Archivierung des Webs immer mehr zu einer Aufgabe der Nationalbibliotheken. Der nationale Webspace wurde als Teil des kulturellen Erbes angesehen und dafür Umsetzungsinitiativen gestartet. Grundvoraussetzung für die Durchführung war in vielen europäischen Ländern eine gesetzliche Ermächtigung zum Sammeln des nationalen Webs. Diese Gesetze wurden nach und nach verabschiedet und ermöglichen seither den meisten Nationalbibliotheken das Sammeln ihres nationalen Webspace und regeln den Zugriff darauf. Auch wenn der Aufruf von gesuchten Webinhalten meist nur vor Ort erlaubt wird, bieten dutzende Webarchive eine öffentliche Suchmöglichkeit an. Kann man über das Internet Archive eine archivierte Webseite nicht finden, so hilft möglicherweise eine Suche in diesen Webarchiven.5

Auch der österreichische Gesetzgeber verbietet leider den Aufruf von archivierten Webseiten außerhalb der Räumlichkeiten der Österreichischen Nationalbibliothek und der dazu berechtigten anderen Bibliotheken.6 Er erlaubt jedoch die öffentliche Suche nach Webseiten über die Webadresse und im Volltext. Das folgende Beispiel zeigt, wie man eine erfolgreiche Suche im Webarchiv Österreich durchführt und sich Suchergebnisse mit Hilfe des Internet Archives, trotz der oben erwähnten Einschränkungen, anzeigen lassen kann.

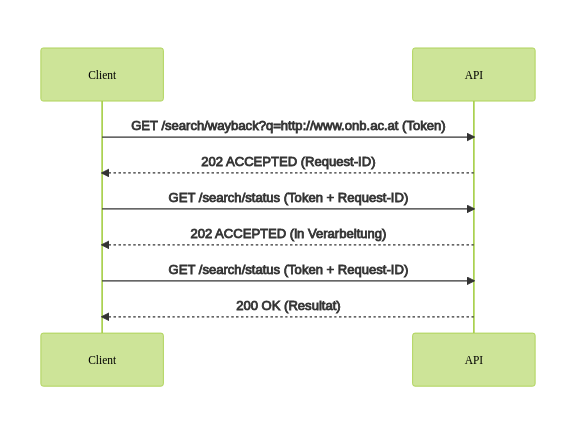

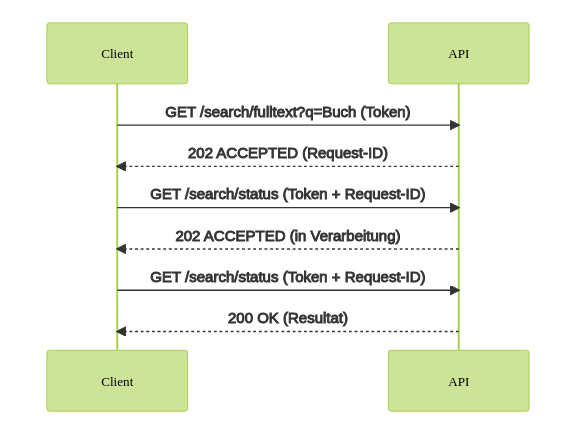

Url-Suche

Als das Webarchiv Österreich vor über zehn Jahren startete, gab es eine Projektbeschreibung auf der Webseite der Österreichischen Nationalbibliothek. Einige Dokumente im Online-Web verweisen noch auf diese Adresse und den damaligen Inhalt.7 Aktuell wird man bei der Eingabe der damaligen Adresse "http://www.onb.ac.at/about/webarchivierung.htm" auf das aktuelle Webportal des Webarchivs Österreich "https://webarchiv.onb.ac.at "weitergeleitet und die ursprüngliche Seite wird nicht mehr angezeigt. Um zu erfahren wie die Webseite ausgesehen hat, gehen wir auf "https://webarchiv.onb.ac.at" und geben in das Sucheingabefeld die alte Webadresse ein und klicken auf "Suchen". Nach einem kurzen Moment erscheint das Suchergebnis in Form einer sogenannten „Heatmap“. Dabei werden die gefundenen Versionen als rote Punkte auf einem Kalenderraster angezeigt. Jeder rote Punkt stellt mindestens eine gespeicherte Version für den jeweiligen Tag dar. Je dunkler der Punkt, desto mehr Versionen der gesuchten Webadresse sind archiviert worden.

Wir wählen den ersten roten Punkt aus, der zugleich die erste gespeicherte und damit älteste Version der gewählten Adresse darstellt. Beim Klick auf den Punkt öffnet sich ein Dialogfenster, in dem alle Zeitschnitte des ausgewählten Tages angezeigt werden. Sobald man auf den Verweis mit dem gewünschten Zeitstempel klickt (in diesem Fall 13:29:05 Uhr vom 16. April 2010), öffnet sich in einer neuen Lasche im Browser die sogenannte Wayback-Machine, die die ausgewählte Version der archivierten Webseite für uns aus den gespeicherten Einzeldateien zusammenstellt und anzeigt.

» https://webarchiv.onb.ac.at/web/20100416132905/http://www.onb.ac.at/about/webarchivierung.htm [7. Dezember 2021]

» https://webarchiv.onb.ac.at/web/20100416132905/http://www.onb.ac.at/about/webarchivierung.htm [7. Dezember 2021]

Dass wir die Adresse unserer Projektwebseite vor über zehn Jahren ausgesucht haben, hat einen besonderen Grund: Unsere eigenen Inhalte dürfen wir in archivierter Form auch online anzeigen. Für alle anderen Inhalte, für die keine speziellen Vereinbarungen mit Medieninhabenden bestehen, lässt sich die archivierte Version aufgrund des Mediengesetzes nicht außerhalb der Räumlichkeiten der Österreichischen Nationalbibliothek aufrufen. Bevor nun Leser*innen unsere Terminals im Haus besuchen, lohnt sich aber noch ein Klick auf den Verweis "Beste IA Version". Über diesen Link wird in einer neuen Lasche die Wayback-Machine des Internet Archives geladen, die die zeitlich näheste Version zum ausgewählten Zeitschnitt im Webarchiv Österreich zu laden versucht.

Bleibt auch diese Suche erfolglos, so bietet die Lasche "Andere Webarchive" eine Liste von Archiven mit öffentlicher Suchmöglichkeit an. Jeder Verweis startet im ausgewählten Webarchiv eine Suche nach allen Versionen der bestimmten Webadresse und zeigt das Ergebnis in einer neuen Lasche des Browsers an.

Volltextsuche

Nicht immer steht die exakte Adresse für den Aufruf einer archivierten Webseite zur Verfügung. Wie bei bekannten Suchmaschinen im Netz kann man auch im Webarchiv Österreich nach Begriffen suchen, um über diesen Weg eine archivierte Webseite zu finden. Auf unserer Projektseite schrieben wir vor zehn Jahren über unsere Mission: "Ziel der Webarchivierung ist die Sammlung und Archivierung des gesamten nationalen Webspace". Gibt man diesen Satz in das Sucheingabefeld ein und setzt die Suche ab, so wird im vorhandenen Volltext (umfasst zurzeit rund fünf Prozent aller archivierten Textdokumente) nach den eingegebenen Begriffen gesucht. Nach einem kurzen Moment erscheint ein Suchergebnis, das die jeweiligen Zeitschnitte einer Webadresse anzeigt, die die gesuchten Begriffe beinhalten. In jeder Ergebniszeile finden Sie den schon bekannten relevanten Zeitstempel oder den Verweis auf die "Beste IA Version", der das zeitlich näheste Ergebnis im Internet Archive für die Suche liefern kann.

Auch wenn in unserem Fall die zeitlich näheste Version im Internet Archive einige Monate vom gewünschten Zeitpunkt entfernt ist, wird doch der gleiche Inhalt angezeigt, da sich die Webseite in diesem Zeitraum nicht verändert hat.

Die Suche nach archivierten Webseiten ist längst nicht so komfortabel wie die gewohnte Suche im Online-Web. Den ersten schnellen Einstieg bietet das Internet Archive mit seinem Webarchiv, das über eine URL- bzw. Schlüsselwortsuche für URLs, die Anzeige archivierter Webseiten bereitstellt. Doch das größte Web-Archiv der Welt ist keineswegs lückenlos. Nationale Webarchive tragen im Rahmen ihrer gesetzlichen Möglichkeiten dazu bei, diese Lücken so gut wie möglich zu schließen. Zudem bieten viele Nationalbibliotheken eine dem Internet Archive fehlende Volltextsuche an und können so Suchergebnisse liefern, die dann mit Hilfe des Internet Archives eventuell rekonstruiert werden können. Finden sich auch dort die gewünschten Inhalte nicht, lohnt sicher ein Besuch in der Nationalbibliothek oder in den berechtigten Bibliotheken, die die gesuchten Inhalte auf speziellen Terminals zur Verfügung stellen können.

Die Österreichische Nationalbibliothek bedankt sich sehr herzlich beim Wiener Städtische Versicherungsverein für die Unterstützung des Webarchivs Österreich.

Über den Autor: Mag. Andreas Predikaka ist technisch Verantwortlicher des Webarchivs Österreich an der Österreichischen Nationalbibliothek.

Quellen:

1 Schon ein Screenshot der besuchten Webseite im Anhang kann hilfreich sein. Auch das zählt als Webarchivierung. Vgl. Brügger, Niels (2018): The Archived Web. Doing History in the Digital Age, Cambridge London: The MIT Press, 80

2 Siehe [Online] https://web.archive.org [7. Dezember 2021]

3 Zum Auftrag des Internet Archive siehe Rossi, Alexis. Internet Archive. Hamburg University Press, 2016, [Online] https://web.archive.org/web/20210718222757/https://hup.sub.uni-hamburg.de/volltexte/2016/168/chapter/HamburgUP_DDB_KulturellesErbe_02_Vielfalt_USA.pdf [7. Dezember 2021]

4 Siehe [Online] https://web.archive.org/web/20211207104627/https://de.wikipedia.org/wiki/Fair_Use [7. Dezember 2021]

5 Siehe [Online] https://web.archive.org/web/20211207113207/https://en.wikipedia.org/wiki/List_of_Web_archiving_initiatives [7. Dezember 2021]

6 Siehe § 43d Abs.4: " die Österreichische Nationalbibliothek und die in § 43b Abs. 7 genannten Bibliotheken [dürfen] gemäß § 43b gesammelte oder abgelieferte Medieninhalte ihren Benutzern nur an ihrem Standort zugänglich machen", [Online] https://web.archive.org/web/20211207120200/https://www.ris.bka.gv.at/Dokumente/BgblAuth/BGBLA_2009_I_8/BGBLA_2009_I_8.html [7. Dezember 2021]

7 z.B. [Online] https://de.slideshare.net/ATWebarchive/bedeutung-der-webarchivierung-nestordnb [7. Dezember 2021]

Wie entsteht die Kollektion Frau/Gender im Webarchiv der ÖNB? Webkurator*innen am Werk

Autor*innen: Andrea Gruber, Lydia Jammernegg, Michaela Mayr, Andreas Predikaka

Wie entsteht die Kollektion Frau/Gender im Webarchiv? - Webkurator*innen am Werk

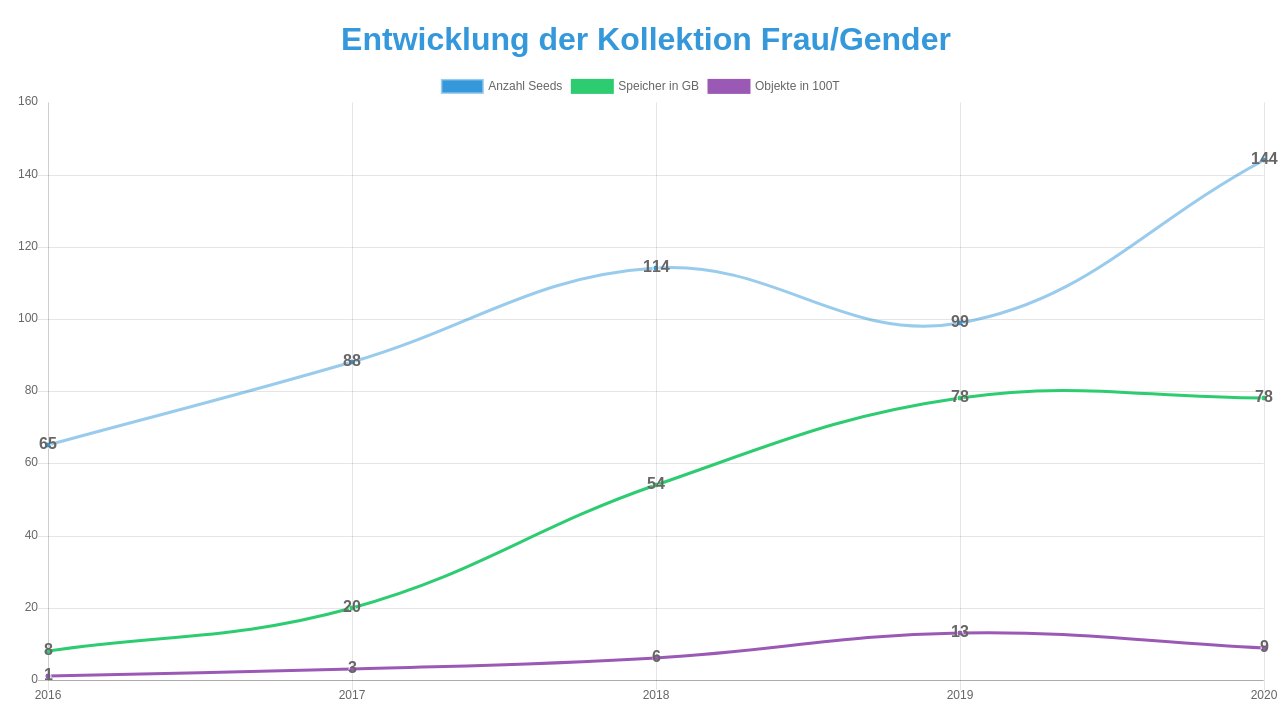

Vom Webarchiv Österreich der Österreichischen Nationalbibliothek werden seit 2009 umfangreiche Web Crawls durchgeführt, um das digitale Kulturerbe im Web zu dokumentieren und langfristig zu sichern. Dabei standen zu Beginn vor allem technische Fragen im Vordergrund – Hardware, Software, Speicherkapazitäten, Crawl-Parameter, Speicher-Intervalle, Webtechnologien usw. Schon bald war klar, dass es neben den jährlichen umfangreichen Domain Crawls auch thematische Schwerpunkte braucht, die ein besonderes Augenmerk erfordern, damit nicht wesentliche Inhalte verloren gehen. So wurden die ersten Kollektionen im Webarchiv begründet, Webseiten aus den Bereichen Medien und Politik werden seither laufend archiviert.

Immer stärker zeigen sich auch in den unterschiedlichen Sammlungen der Österreichischen Nationalbibliothek die Anknüpfungspunkte zu born digital Medien. Die Kollektion Frau/Gender ist ein Paradebeispiel für die nachfolgend näher beschriebene Zusammenarbeit von Webarchiv-Expert*innen und Fachbibliothekar*innen, die als Webkurator*innen wichtigen inhaltlichen Input leisten.

Entstehungsgeschichte – Rückblick

Im Rahmen einer Abschlussarbeit, die von Ariadne im Rahmen des Universitätslehrgangs für Library and Information Studies 2015 zum Thema „Ariadne 4.0. Dokumentation und Archivierung von digital born Quellen aus dem Gebiet der feministischen-, Frauen- und Geschlechterforschung“ vergeben wurde, entwickelte sich die Kooperation mit dem Webarchiv Österreich. Damit konnte Ariadne an das Thema Dokumentation und Archivierung von digital born Medien anknüpfen.